Пару недель назад я совершенно случайно обнаружил в Яндекс.Вебмастере плашку о фатальной ошибке. Там было написано, что мой сайт может угрожать безопасности пользователя, или на нём были обнаружены нарушения правил поисковой системы. Других ошибок не было: индекс качества даже немного подрос.

Удивительно было, что этот сайт — известное в регионе СМИ, и вопросов к нему со стороны Яндекса не было все восемь лет его существования. Потому что мы и на самом деле нарушениями правил поисковиков не занимаемся. Но сначала я, конечно, подумал, что проблема в нас самих — где‑то спрятался баг или, того хуже, взломали. Однако, всё оказалось куда интереснее.

Дело оказалось в новом алгоритме Яндекса, который теперь буквально запрещает писать новости. И в нашей области он уже забанил примерно треть независимых региональных СМИ. Причём под удар, на удивление, попали одни из самых качественных. Поэтому я считаю, что проблема здесь не столько в сайтах, сколько в самом алгоритме, создатели которого придумали хорошую идею по борьбе за уникальность контента, но не до конца её протестировали. Почему я пришёл к такому выводу и что конкретно с алгоритмом не так, я здесь и расскажу.

Пару слов о себе. Меня зовут Вадим, и больше десяти лет я занимаюсь региональными СМИ, причём, где‑то на стыке журналистики и IT. С одной стороны, я всегда любил писать тексты, с другой — мне не менее интересно настраивать и дорабатывать CMS и следить за алгоритмами рекомендательных и поисковых систем. И вот, кстати, было заметно, что алгоритмы улучшались с каждым годом, и мой ответ начинающим на вопрос «как мне писать, чтобы мой текст полюбили поисковики» всё увереннее звучал так: «просто пиши хороший текст для людей, они этого от тебя и хотят». Что меня радовало, но, в случае с Яндексом, так продолжалось лишь до недавнего времени.

Просто станьте лучше

Итак, я обнаружил в Вебмастере плашку о фатальной ошибке и проблемах с безопасностью. По клику на подробности конкретики стало больше: «Малополезный контент, обилие рекламы или спам». И тут я даже как‑то обиделся. Потому что над контентом работает целая редакция, и, например, свои тексты я через полдня вижу во всех городских пабликах, а вечером мне их начинают пересказывать знакомые. То есть малополезными наши материалы назвать нельзя. Вся реклама на сайте — это один аккуратный блок Яндекс.Директа под текстом, пресс‑релизы в отдельном разделе и периодически один‑два баннера — небольших, не всплывающих и без видео.

Вдвойне обидно, что буквально за неделю до бана я чуть ли не матом послал очередного продажника, который искренне удивлялся, почему мы не хотим поставить поп‑ап с видео, ведь он «совсем маленький», и не понимал, что значит «мы не хотим издеваться над своими читателями» и как мы можем от денег отказываться. Наконец, спама у нас тоже точно не было и покупкой ссылок мы не пользовались — на нас и так активно ссылаются.

Но что‑то же заставило Яндекс убрать сайт из поиска. Хотя это мягко названо «ограничениями», фактически сайт можно найти только если искать целенаправленно его. По запросам большинство текстов из выдачи пропало, даже если вводить в поисковую строку их заголовок. Яндекс.Вебмастер ответа на вопрос «почему так случилось» не давал: по его данным в целом всё было хорошо. Индекс качества сайта даже подрос, конкретных ошибок не было. Кроме одной — но фатальной. С такими вводными я вообще перестал понимать смысл этого сервиса и его многочисленных функций.

За подсказками я обратился в техподдержку. В старые добрые времена там удавалось найти понимание и быстро выловить баги — как свои, так и самого Яндекса.

Например, однажды у того же сайта забанили турбо‑страницы только потому, что робот Яндекса неправильно распознавал расположение даты публикации. В шапке сайта у нас была указана текущая дата, робот принимал за дату публикации текста именно её, сверял с датой в RSS для турбо‑страниц и предсказуемо ругался — ведь они не сходились. В поддержке заметили этот момент, мы убрали текущую дату из шапки, робот перестал путаться и всё нормализовалось.

Но теперь стало сложнее. Ответ пришлось выуживать по крупицам. Поддержка просто копировала фразы из справки и советовала устранить причины бана, давая ссылку на страницу справки, где были перечислены вообще все возможные причины, включая мошенничество и ссылки на скачивание вирусов. Затем уверяла, что нужно просто писать качественные тексты и всё наладится. Советовала взглянуть на сайт глазами пользователя (тут опять было обидно, потому что именно так мы на него всегда и смотрели). И, наконец, с формулировкой «ваш сайт ещё недостаточно качественный» рекомендовала комплексно его улучшать. Учитывая, что количество публикаций на нём за восемь лет работы подобралось к 40 тысячам, это уже звучало как призыв просто грохнуть весь архив СМИ и начать заново.

Я перешел в наступление, требуя не копировать мне содержимое справки, а сказать, что же всё-таки не так конкретно у нас. На возражения о том, что поисковые системы своих алгоритмов не раскрывают, парировав: я не прошу алгоритмы, но, если вы обвиняете нас в нарушении правил, то скажите хоть каких. Речь же уже не о месте в выдаче, а о том, что нас фактически перестали индексировать.

Нейросеть против рерайта

И мне назвали возможную причину. Ей оказалось вышедшее в августе обновление алгоритмов поиска, призванное бороться с неоригинальным контентом. Правда, в техподдержке сразу оговорились: это возможная, но не единственная причина, и решение о бане принято «по совокупности факторов» (это тоже оказалась копия текста из справки, а не конкретно про нас). А потом снова ушли в отрицание. На просьбу проверить адекватность алгоритма быстро ответили, что всё досконально проверили и всё работает правильно. Просто нам работать надо лучше над сайтом.

Но про алгоритм — уже интересно. Судя по описанию, это нейросеть, которая умеет понимать смысл текста и поэтому замечает, когда одно и то же сказано разными словами. Вот, что про это пишут в блоге Вебмастера:

"Само по себе цитирование материалов допустимо и не является нарушением. Другое дело, если цитирование или рерайт образуют основной контент сайта, — такой ресурс не представляет реальной ценности для пользователей"

При этом ниже перечислен список того, что можно цитировать - законы, авторские описания, художественные произведения. То есть авторы алгоритма о исключениях подумали. Но заканчивается список расплывчатым "...и в других случаях, когда в результате пользователи получают дополнительную ценность".

Так вот. Я бы добавил туда дополнительный пункт. Вы можете рерайтить, если вы СМИ. Особенно если новостное.

Почему рерайт для СМИ — это норма

Всё дело в особенностях работы СМИ, тем более в регионах. Событий происходит не так уж много, поэтому, если о чём‑то написало одно издание — напишут и другие. Чего далеко ходить: можно посмотреть новостной раздел Хабра, там то же самое. Нельзя писать все новости первым, и в то же время нельзя не писать резонансную новость только потому, что первым о ней узнал не ты. У читателей будут вопросики. Но значит ли это, что пользователь не получает дополнительной ценности? Нет!

Разные СМИ делают разную подачу материала, занимаются переводом с официального языка на человеческий, ищут дополнительные подробности. Это в хорошем смысле конкуренция, которая заставляет быть лучше и не расслабляться. А ещё хорошо написанные новости дают трафик, который тянет за собой просмотры больших репортажей.

Когда‑то давно, когда я был совсем маленьким интернет‑журналистом, я думал открыть что‑то вроде регионального интернет‑журнала. Чтобы без этих ваших новостей, только большие и интересные тексты! Ожидания быстро столкнулись с реальностью: привлечь аудиторию таким образом сложно, ведь люди должны как‑то ещё оказаться на сайте, чтобы узнать, что там есть, что почитать. А вот если сочетать лонгриды с новостями — расходятся и новости, и твои репортажи.

Но новости, по мнению нового алгоритма Яндекса, это сплошной рерайт. Ведь если текст о событии умещается в пару абзацев, то его смысл будет одинаковым, даже если ты сам видел происходящее и к конкурентам не заглядывал. А значит, считает алгоритм, региональное СМИ — по умолчанию бесполезный сайт, который еще должен доказать, что ему место в поисковой выдаче.

Самое интересное здесь, что много лет Яндекс — пока в него входил сервис Яндекс.Новости, наоборот стимулировал рерайт. В топ новостей невозможно было попасть со своей уникальной темой. Алгоритм считал (и во многом справедливо), что, если об этом написал ты один, это не такая уж новость. Вот если её же написали (или переписали) твои коллеги — тогда да, добро пожаловать в топ за трафиком. Чем больше рерайта — тем выше новость в топе, ведь раз про это пишут все — значит событие значимое.

Но то было давно, Новости уже у другого собственника, а у Яндекса — новый алгоритм. Который просканировал всё, что накопилось за эти годы, ужаснулся количеству рерайта (новостей же по определению больше, чем репортажей) и отправил сайт в бан. Вроде бы даже логично, но.

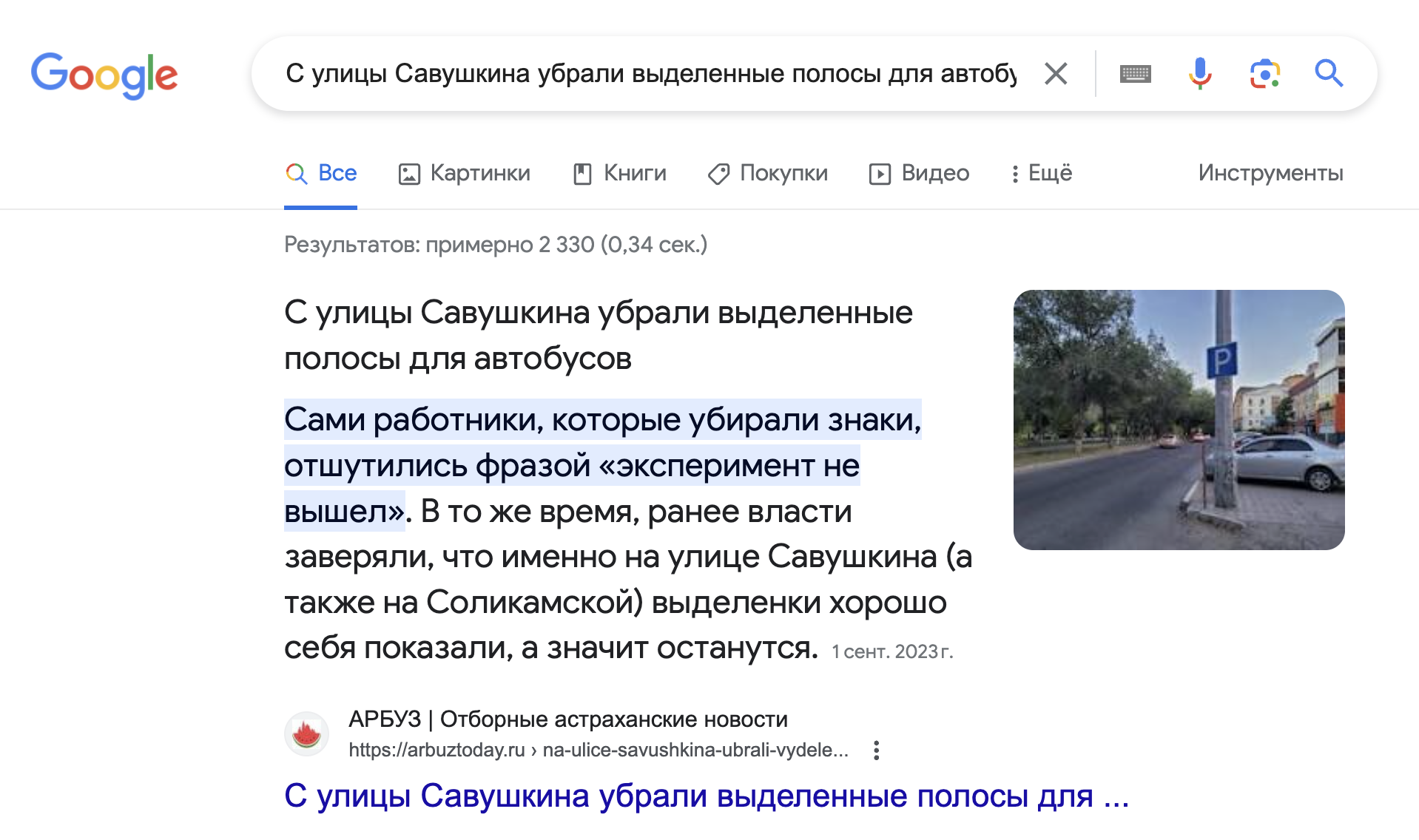

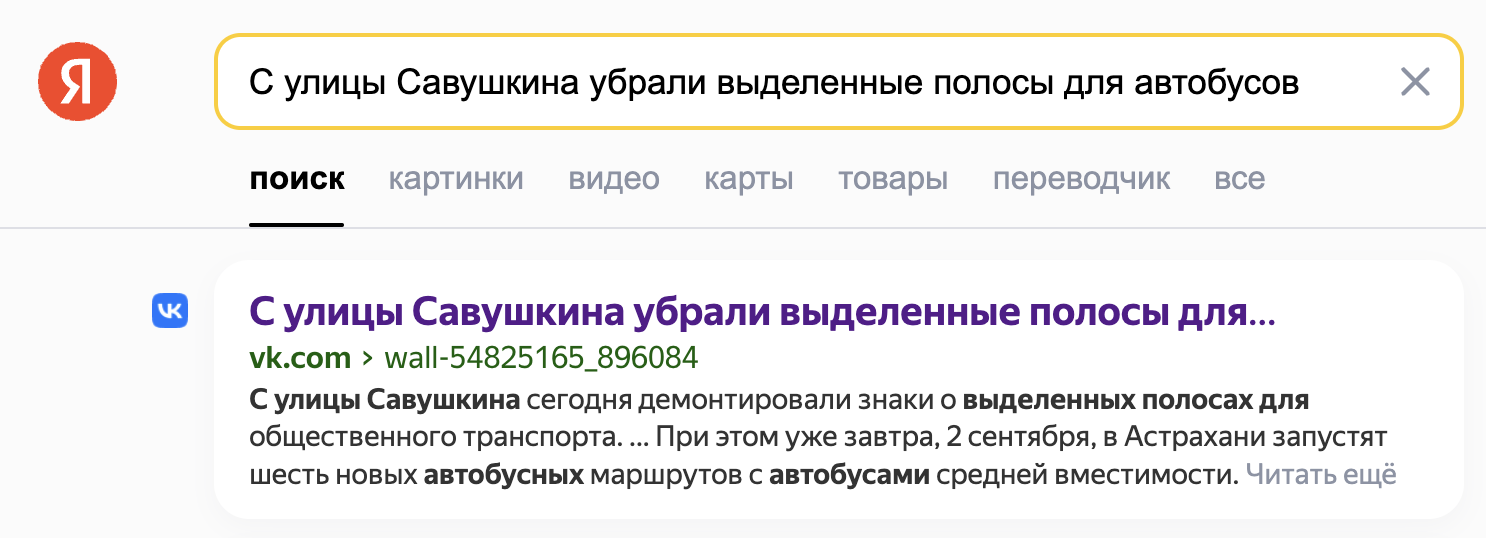

Я напомню: сайт не состоит из рерайта. Уникального контента на сайте тоже хватает — в том числе и новостей, которые мы нашли первыми. Этот контент по‑прежнему воруют без ссылок разные паблики ВКонтакте и местные Телеграм‑каналы. Только теперь, если я ввожу в поиск цитаты из своих авторских текстов, Гугл, как прежде, выдает мне реальный первоисточник — наше СМИ, а Яндекс — только паблики. Которые просто скопировали мой текст вместе с фото, поставили к себе и теперь первые в выдаче. ВКонтакте же не забанишь.

Пошли вон из выдачи

Как я уже писал в начале, в нашем регионе из выдачи Яндекса исчезла примерно треть СМИ. Принципа, по которому алгоритму не понравились именно они, я так и не понял. Уникальный контент у них как раз есть, одним из первых под удар нейросети вообще попало издание, которое в регионе известно большими авторскими репортажами. У него проблемы возникли даже раньше, чем у нас. Из тенденций заметил только, что в выдаче остались все государственные телекомпании (тут, возможно, роль сыграло видео) и все издания-новички (кому еще не больше лет пяти). Последние, предполагаю, ещё просто не успели достаточно нарерайтить.

Что мы делаем сейчас? Ищем пуговицу. Правим всякие мелочи, которые могут потенциально не нравиться поисковику, вроде закрытых и открытых от индексации разделов. Уже отказались от нескольких рекламодателей, чтобы уменьшить долю рекламных текстов на сайте (хотя они и так не мешают пользователям, но другой рекламы, от которой можно было бы отказаться, у нас и нет, если только Яндекс не ругается на свой Директ). И надеемся, что Яндекс всё‑таки поправит свои алгоритмы, или хотя бы объяснит, что ему не так и что нам надо в этой ситуации делать.

P.S.

Уже когда этот текст лежал в черновиках, техподдержка Яндекса написала по итогам более детальной проверки алгоритма. Её стали проводить после того, как я привёл пример с копиями моего же текста в чужих пабликах, которые, в отличие от оригинала, в выдаче были. Я спросил, то ли это, чего разработчики хотели от алгоритма, который должен был бороться за уникальный контент.

Ответ пришёл спустя несколько дней, там мне снова подтвердили, что алгоритм так и должен работать. Но появилась и новая информация, не дает поводов для оптимизма тем, кто причастен к СМИ:

«Замечу, что алгоритм внедряется постепенно, чтобы вебмастера могли обратить внимание на потенциальную проблему и решить её, улучшив качество своего сайта. Но со временем все сайты с подобными нарушениями будут ограничены в ранжировании, если их владельцы не прислушаются к нашим рекомендациям»

То есть, если издание ещё не убрали из выдачи - возможно, это не его заслуга, просто нейросеть ещё не катится по его улице. Впрочем, спастись просто: нужно лишь прислушаться к рекомендациям стать лучше. Подозреваю, что техподдержка и сама может не знать, что в сайте не понравилось нейросети. Она показала, что сайт плохой, и вопрос закрыт. Алгоритм умный, нет оснований ему не доверять. Будущее наступило. Смиритесь.

Кстати, если меня читают сотрудники Яндекса: я готов помочь, чтобы решить проблему вместе. С радостью уделю время, чтобы разобраться, как отличить хороший региональный контент от плохого. Всё-таки опыта в этом у меня через край. Ведь в целом алгоритм и правда интересный, и проблема с копированием авторского контента кем ни попадя действительно существует. Но, честное слово, в нынешнем виде ему нужна доработка.

Автор:

ganzmavag