Рубрика «ЦОДы»

Топ-10 мифов о публичных облаках в корпоративном сегменте

2025-09-29 в 7:06, admin, рубрики: cloud efficiency, finops, дата-центр, инфраструктура, облака, облачная инфраструктура, оптимизация расходов, сервисы, ЦОДы

От капитального ЦОДа к гибкому модулю: куда идёт российская ИТ-инфраструктура

2025-07-08 в 13:01, admin, рубрики: gpu, ruvds_статьи, дата-центр, модульный цод, облака, серверы, хранение данных, цод, ЦОДы

В марте 2025 года Sitronics Group опубликовала прогноз: к 2030 году рынок модульных дата-центров в России вырастет в 2,5 разаЧитать полностью »

Пять типичных ошибок в энергоснабжении ЦОД. Как избежать блэкаута

2025-02-11 в 10:43, admin, рубрики: бесперебойное питание, бесперебойное электроснабжение, ИБП, серверы, ЦОДы, энергоснабжениеНадежная система электроснабжения — это сердце любого ЦОД, будь то маленькая серверная или коммерческий дата-центр на несколько тысяч стоек. Даже малейшие сбои могут привести к остановке всего комплекса с сопутствующими репутационными и коммерческими потерями.

В нашей практике мы встречаемся с самыми удивительными решениями в части инженерных систем, и сегодня Кирилл Дмитриев, архитектор инженерных систем центра сетевых решений «Инфосистемы Джет», разберет пять самых распространенных проблем.

Как сгладить облачные турбулентности

2025-01-15 в 14:33, admin, рубрики: data center, балансировщик, цод, цод и хранение данных, ЦОДыОт КАМАЗа до природного газа. Самые интересные статьи про дата-центры за год

2022-01-07 в 7:02, admin, рубрики: Блог компании Selectel, дата-центр, дата-центры, инженерные системы, цод, ЦОДы

Привет!

В прошлом году мы много писали про дата-центры. Условно наши статьи можно разделить на 3 группы:

-

необычные локации,

-

новые технологии,

-

личный опыт.

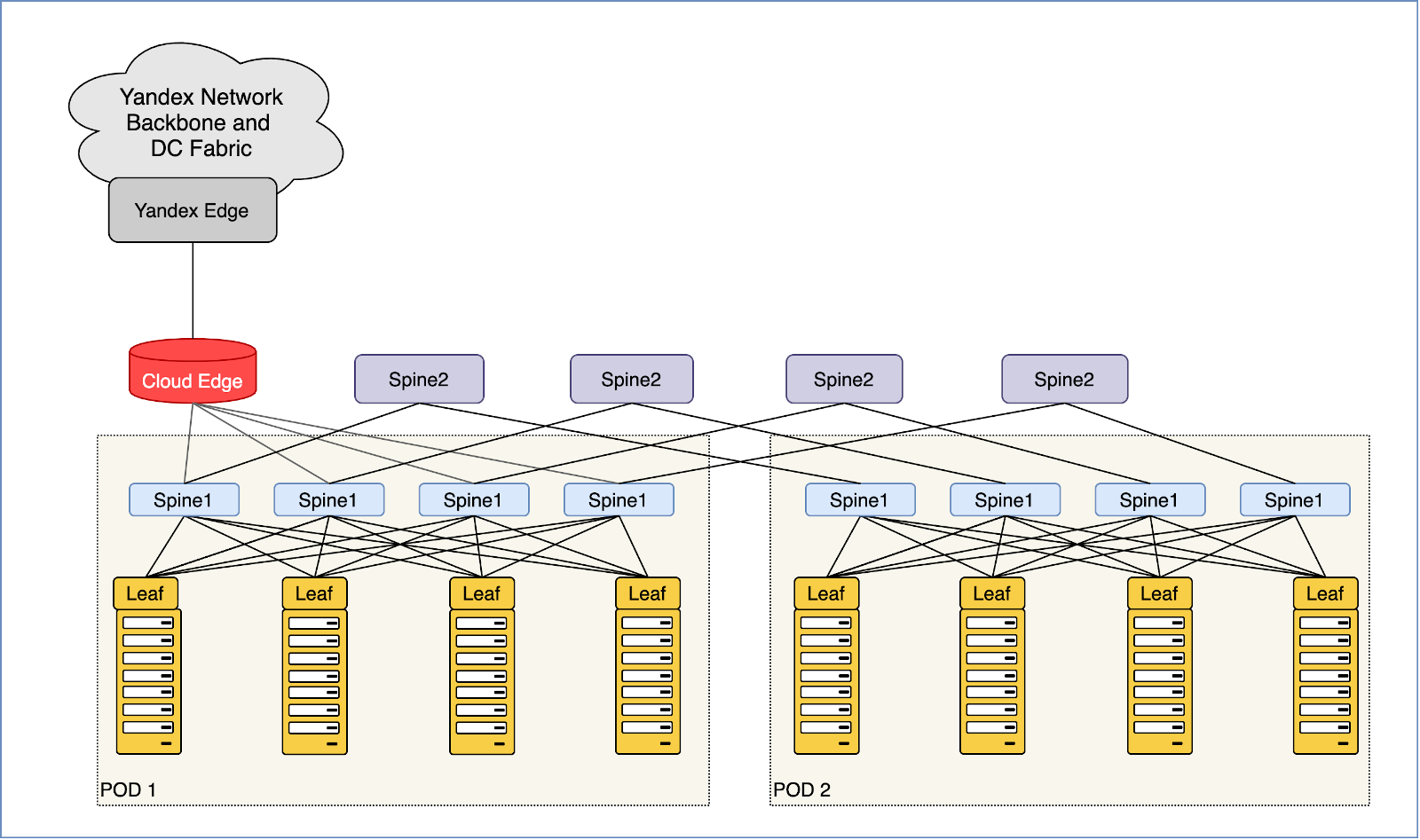

Как превратить две серверные стойки в сеть для десятков тысяч машин и не остаться в неоплатном техническом долгу

2021-04-08 в 8:02, admin, рубрики: Clos, автоматизация, Блог компании Яндекс, датацентры, команда яндекс.облака, масштабируемость, облачные сервисы, отказоустойчивость, Серверное администрирование, сетевая автоматизация, Сетевые технологии, сети, ЦОДы, Шарль Кло или Чарльз Клоз?, яндекс.облакоКак и любое другое облако, Yandex.Cloud — это многослойная иерархия абстракций: SaaS, лежащий поверх PaaS, запущенный на IaaS. Связность виртуальной инфраструктуры обеспечивает виртуальная же сеть, которая является, по сути, оверлеем. И только в самой глубине этой системы обнаруживается физическая сеть из проводов и коммутаторов. Мало кто вспоминает о ней, пока всё работает. А меж тем она — кровеносная система всей платформы.

Привет, я Марат Сибгатулин, сетевой инженер Yandex.Cloud. Яндекс про свою сеть рассказывал уже не раз. И про её физическую инфраструктуру, и про особенности устройства Yandex.Cloud, и про то, как вообще работает виртуальная сеть. Не буду повторяться. Расскажу о том, как мы запустили публичное облако на том, что было — на двух стойках, и масштабировали его до сети для десятков тысяч серверов, не наращивая неоплатный технический долг.

Мы практикуем следующий подход к созданию и развитию чего бы то ни было: прототип → минимально необходимая функциональность и масштаб → рост → эволюционное развитие. На первый взгляд он естественен и очевиден, в отличие от подхода «сделать сразу идеально и на века». На деле — требует вдумчивого предварительного планирования, чтобы потом не подставлять в горячке новые костыли под старые, пытаясь поспеть за внезапным ростом.

Читать полностью »

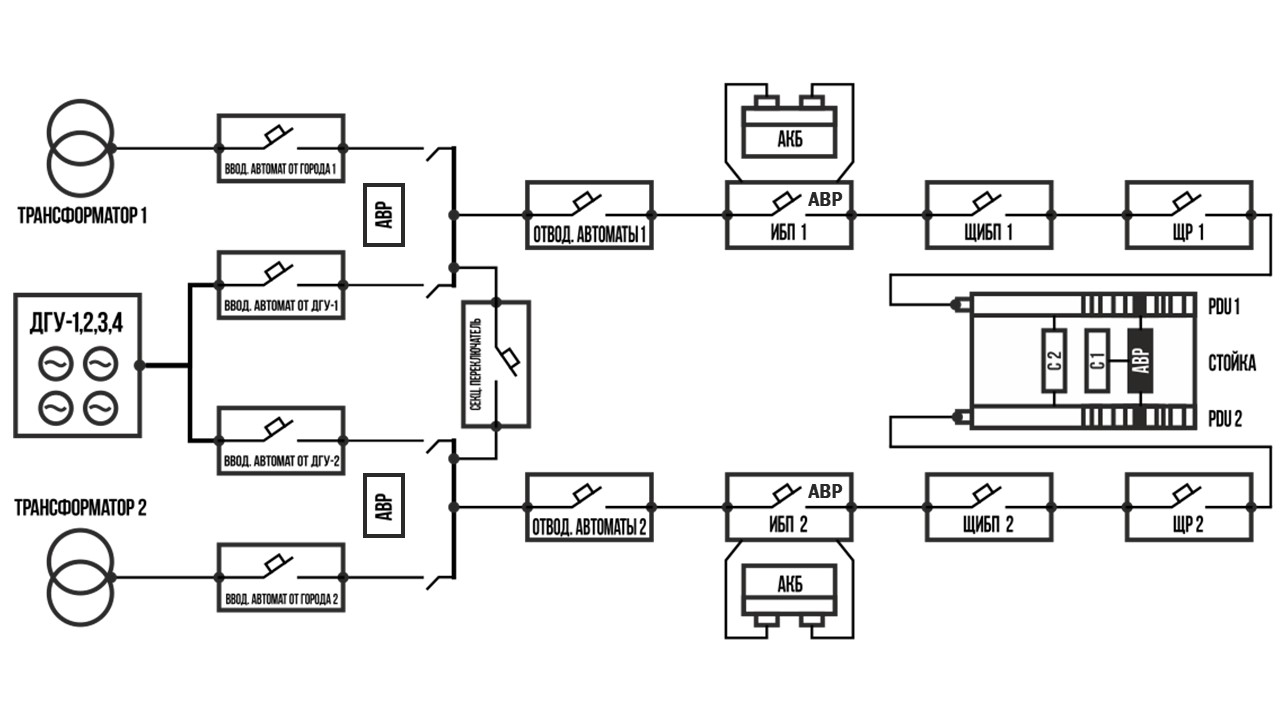

АВР и все, все, все: автоматический ввод резерва в дата-центре

2020-03-12 в 9:04, admin, рубрики: ABP, pdu, Блог компании DataLine, дата-центры, инженерные системы, облачные сервисы, пду, питание, распределение питания, ЦОДыВ прошлом посте про PDU мы говорили, что в некоторых стойках установлен АВР — автоматический ввод резерва. Но на самом деле в ЦОДе АВР ставят не только в стойке, но и на всем пути электричества. В разных местах они решают разные задачи:

- в главных распределительных щитах (ГРЩ) АВР переключает нагрузку между вводом от города и резервным питанием от дизель-генераторных установок (ДГУ);

- в источниках бесперебойного питания (ИБП) АВР переключает нагрузку с основного ввода на байпас (об этом чуть ниже);

- в стойках АВР переключает нагрузку с одного ввода на другой в случае возникновения проблем с одним из вводов.

АВР в стандартной схеме энергоснабжения дата-центров DataLine.

О том, какие АВР и где используются, и поговорим сегодня.

Читать полностью »

PDU и все-все-все: распределение питания в стойке

2019-10-17 в 7:37, admin, рубрики: ABP, pdu, Блог компании DataLine, дата-центры, инженерные системы, пду, питание, распределение питания, ЦОДы

Одна из стоек внутренней виртуализации. Заморочились с цветовой индикацией кабелей: оранжевый обозначает нечетный ввод по питанию, зеленый – четный.

Мы тут чаще всего рассказываем про “крупняк” – чиллеры, ДГУ, ГРЩ. Сегодня речь пойдет о “мелочах” – розетки в стойках, они же Power Distribution Unit (PDU). В наших дата-центрах более 4 тысяч стоек, забитых ИТ-оборудованием, поэтому в деле я видел много всякого: классические PDU, “умные” – с мониторингом и управлением, обычные блоки розеток. Сегодня расскажу, какие PDU бывают и что лучше выбрать в конкретной ситуации. Читать полностью »

Прогулки по ЦОДам и телекомам Питера

2019-06-12 в 6:04, admin, рубрики: linkmeup, датацентры, Сетевое оборудование, Сетевые технологии, системное администрирование, ЦОДыПервые дни лета отлично подходят для развивающей поездки в Питер.

Мы посетим Миран, linxdatacenter, RETN и Метротек.

5 утра, Московский вокзал, KFC, набережная Мойки, Тарелка, голуби с крыш, Исакий, Марсово поле, Каптюр яндексодрайвовый, и вот он — Миран.

Миран

В Миране уже несколько лет проживает наша лаба с Евой, сервер трансляции, виртуальный микротиковский Роутэрос, хостинг linkmeup с IPv6-доступностью и теперь хостинг подкастов.

Три истории модернизации в дата-центре

2018-11-29 в 7:01, admin, рубрики: dataline, Блог компании DataLine, дата-центр, дата-центры, даталайн, инженерная инфраструктура, машинный зал, модернизация, управление проектами, холодоснабжение, цод, ЦОДы, чиллеры, энергоснабжениеПривет! В этом году – 10 лет, как запущен наш первый ЦОД OST-1. За это время мы с коллегами из службы эксплуатации и капитального строительства успели провести не одну модернизацию инженерной инфраструктуры дата-центра. Сегодня расскажу про самые интересные случаи.

200-тонный кран устанавливает новый чиллер Stulz на раму. Модернизация системы холодоснабжения системы дата-центра OST-1 в 2015 году.Читать полностью »