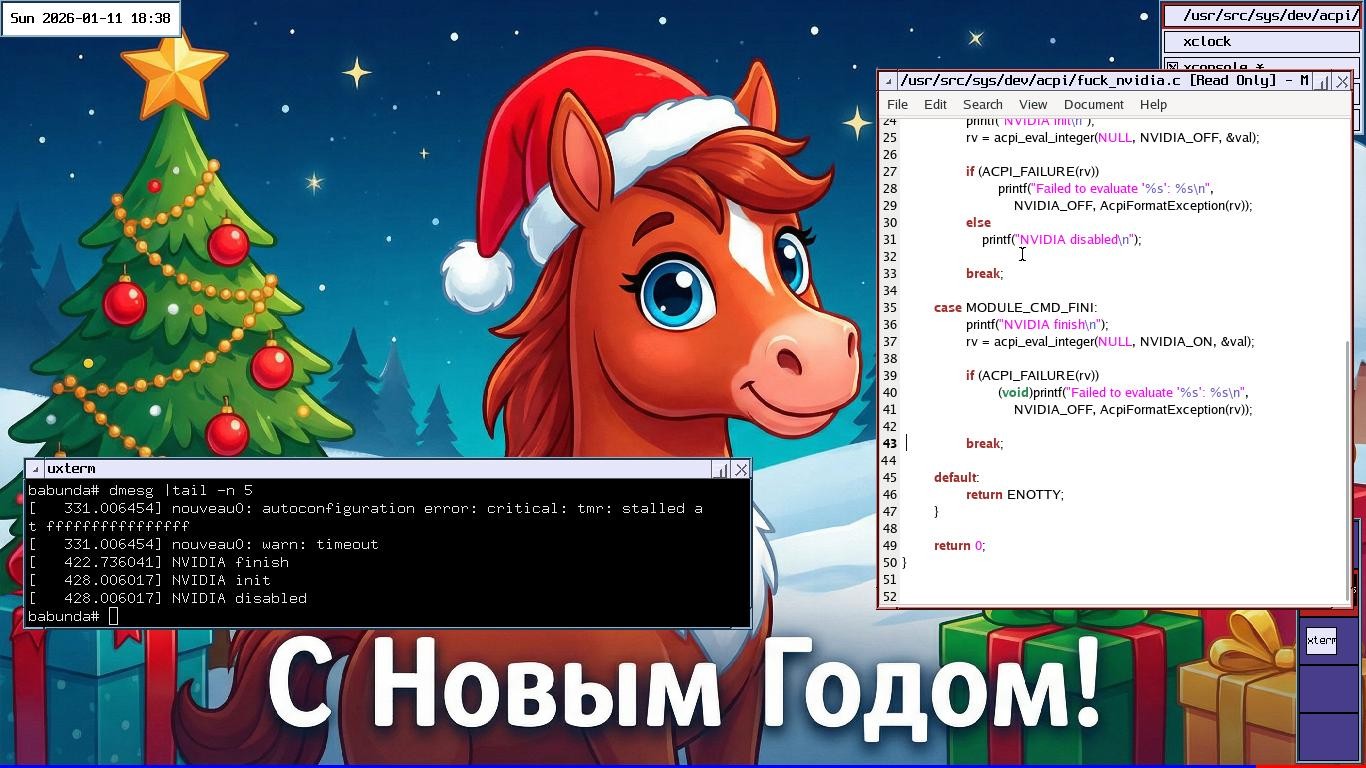

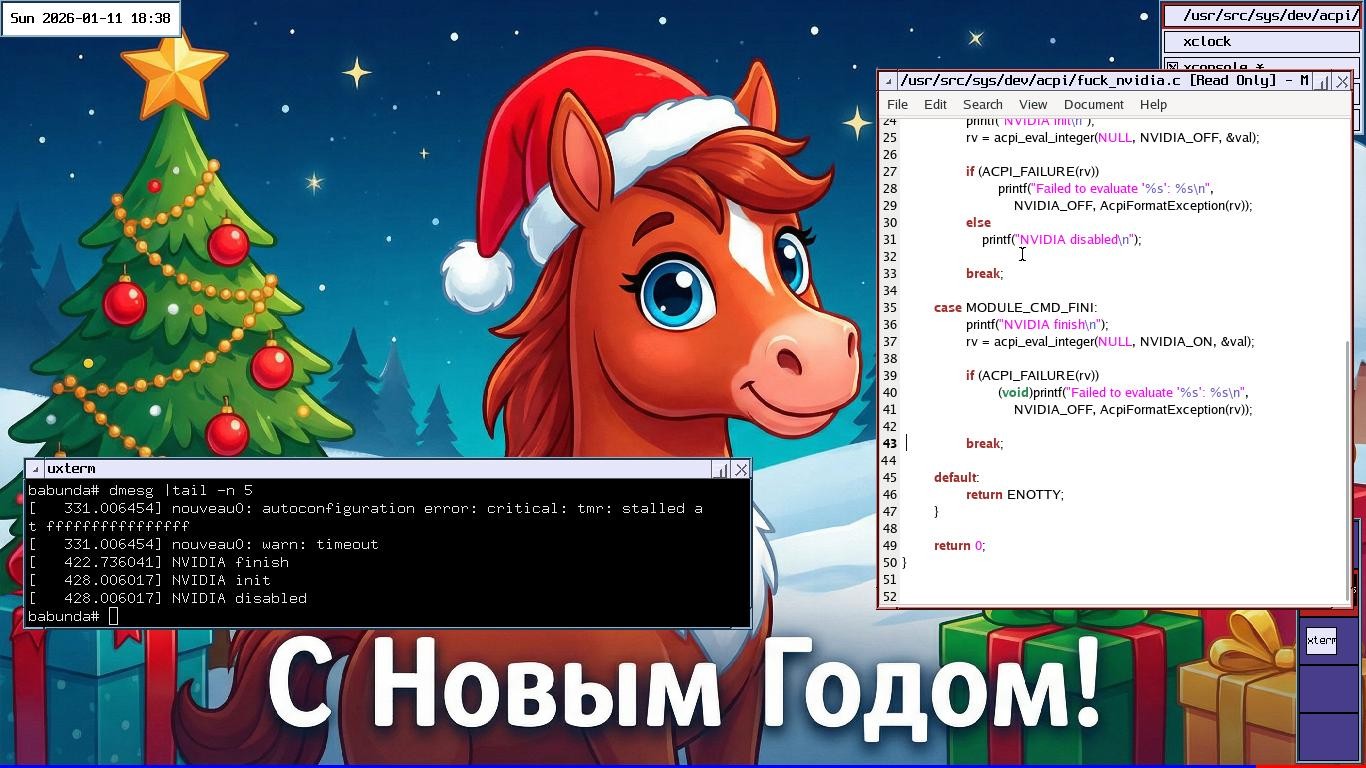

Чтобы задать уровень выдаваемой дичи сразу на весь 2026 год вперед, я написал эту замечательную статью.

Чтобы задать уровень выдаваемой дичи сразу на весь 2026 год вперед, я написал эту замечательную статью.

Ещё раз о ЦП для машинного обучения в эпоху дефицита мощностей GPU

Потихоньку приближается 2026 год, который принесет много интересных событий в сфере ИИ (по крайней мере, так думаю я). Но и за 2025-й мы получили огромное количество отличных моделей в свое распоряжение. С одной стороны, здорово, что теперь можно легко создать текст, программу, изображение, видео и звук. С другой же стороны, такой стремительный прогресс в области искусственного интеллекта существенно повлиял и на аппаратное обеспечение - особенно на видеокарты и память.

Слышите из каждого утюга про «эй-ай» и хотите разобраться в этом тренде? Или просто собрались попробовать запустить ML- или AI-проект, но вас пугают настройки серверов и облаков?