Решая соревнования на Kaggle начинаешь замечать паттерн. Baseline сделать просто: загрузить данные, запустить CatBoost или LightGBM, получить baseline метрику. Это занимает полчаса. Но чтобы попасть в топ решений, нужно перепробовать десятки вариантов препроцессинга, сотни комбинаций фичей и тысячи наборов гиперпараметров.

Рубрика «AutoML»

Автоматизируем машинное обучение с помощью ИИ-агентов

2025-12-03 в 6:15, admin, рубрики: ai-агенты, AutoML, llm, python, машинное обучениеКак LLM помогают ученым

2025-10-08 в 12:40, admin, рубрики: AutoML, github, llm, open source, искусственный интеллект, итмо, наука, Университет ИТМО, химияВсем привет! Меня зовут Николай Никитин, я руковожу лабораторией автоматического машинного обучения в Институте ИИ ИТМО. Сегодня я бы хотел сделать небольшой экскурс в то, как методы и модели ИИ позволяют автоматизировать решение прикладных задачам в разных областях науки.

Нейросети уже достигли впечатляющих результатов ― вспомним хотя бы нобелевскую премию по химии прошлого года, выданную за методы фолдинга белков, проработанные с участием AlphaFold. И различные полезные для ученых решения, появляются каждый день во многих областях.

Как мы в Авито предсказываем категории объявлений по описанию

2025-04-25 в 9:30, admin, рубрики: AutoML, labeling, machinelearning, ml, mlops, nlpПривет! Меня зовут Руслан Гилязев, я работаю в подразделении DS SWAT в Авито, руковожу командой платформы Item2param. Одна из моих задач — развивать модели, которые предсказывают параметры объявлений. В этой статье расскажу, с помощью каких технологий мы решаем задачу классификации объявлений и почему это важно для бизнеса. Материал будет полезен DS-инженерам любого грейда и backend-инженерам, которые интересуются темой Data Science.

Архитектура проекта автоматического обучения ML-моделей

2025-04-17 в 12:45, admin, рубрики: AutoML, data science, machine learning, pythonНа связи Кравцов Кирилл и Суздалев Руслан из команды моделирования поведенческих сценариев Центра развития искусственного интеллекта СПАО «Ингосстрах» (далее – ЦРИИ). В статье поделимся решением, которое помогает нам быстрее обучать и интегрировать модели в компании.

С ростом компании и ЦРИИ, в частности, у нас появлялось все больше бизнес-заказчиков, которым нужны были ML-модели. Поэтому потребность росла, а ограниченность ресурсов не позволяла быстро обрабатывать задачи бизнеса и многое уходило в беклог.

AutoML и NAS

2025-03-10 в 17:49, admin, рубрики: AutoML, ml, NAS, искусственный интеллект, машинное обучение, оптимизация гиперпараметров, ШВМ, Школа Высшей МатематикиАвтор статьи: Сергей Артамонов - DS Wildberries, Research Engineer Skoltech, аспирант мехмата МГУ, преподаватель Школы Высшей Математики

7 лет хайпа нейросетей в графиках и вдохновляющие перспективы Deep Learning 2020-х

2019-12-25 в 7:01, admin, рубрики: alexnet, AutoML, Batch Normalization, big data, cnn, computer science, data science, deep learning, Deepfake, deeplab, DenseNet, dropout, GAN, hardware acceleration, pytorch, resnet, TensorFlow, vgg, искусственный интеллект, машинное обучение, Научно-популярное, нейросети, скорость прогресса, Статистика в IT

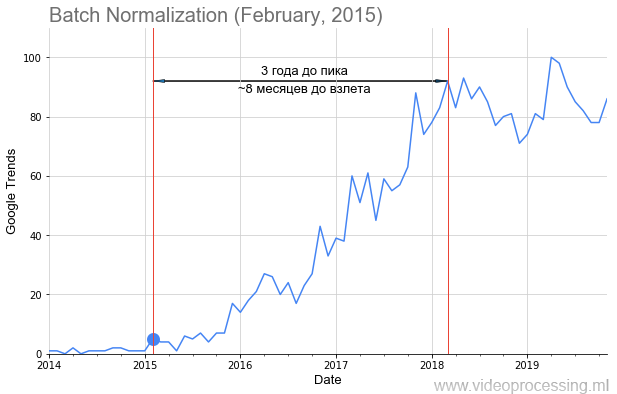

Новый год все ближе, скоро закончатся 2010-е годы, подарившие миру нашумевший ренессанс нейросетей. Мне не давала покоя и лишала сна простая мысль: «Как можно ретроспективно прикинуть скорость развития нейросетей?» Ибо «Тот, кто знает прошлое — тот знает и будущее». Как быстро «взлетали» разные алгоритмы? Как вообще можно оценить скорость прогресса в этой области и прикинуть скорость прогресса в следующем десятилетии?

Понятно, что можно примерно посчитать количество статей по разным областям. Метод не идеальный, нужно учитывать подобласти, но в целом можно пробовать. Дарю идею, по Google Scholar (BatchNorm) это вполне реально! Можно считать новые датасеты, можно новые курсы. Ваш же покорный слуга, перебрав несколько вариантов, остановился на Google Trends (BatchNorm).

Мы с коллегами взяли запросы основных технологий ML/DL, например, Batch Normalization, как на картинке выше, точкой добавили дату публикации статьи и получили вполне себе график взлета популярности темы. Но не у всех тем путь усыпан розами взлет такой явный и красивый, как у батчнорма. Некоторые термины, например регуляризацию или skip connections, вообще не получилось построить из-за зашумленности данных. Но в целом тренды собрать удалось.

Кому интересно, что получилось — добро пожаловать под кат!

Читать полностью »

ИИ от Google обучил дочерний ИИ, который превосходит все ИИ, созданные человеком

2017-12-04 в 13:48, admin, рубрики: AutoML, CIFAR-10, COCO, ImageNet, NASNet, open source, искусственный интеллект, нейросеть, Софт

В мае 2017 года исследователи из Google Brain представили проект AutoML, который автоматизирует проектирование моделей машинного обучения. Эксперименты с AutoML показали, что эта система может генерировать маленькие нейросети с очень хорошими показателями — вполне сравнимые с нейросетями, которые спроектированы и обучены экспертами-людьми. Однако поначалу возможности AutoML были ограничены маленькими научными наборами данных вроде CIFAR-10 и Penn Treebank.

Инженеры Google задумались — а что если поставить перед генератором ИИ более серьёзные задачи? Способна ли эта система ИИ сгенерировать другую ИИ, которая будет лучше созданного человеком ИИ в какой-нибудь важной задаче вроде классификации объектов из базы ImageNet — самого известного из крупномасштабных наборов данных в машинном зрении. Так появилась нейросеть NASNet, созданная практически без участия человека.

Читать полностью »

Системы ИИ научились создавать умные модели для ML: дайджест для начинающих

2017-12-03 в 12:32, admin, рубрики: 1cloud, AutoML, Блог компании 1cloud.ru, дайдждест, машинное обучениеВ ноябре участники исследовательского проекта Google Brain опубликовали результаты эксперимента AutoML. Им удалось создать систему, которая порождает новые ИИ-модели, используя метод обучения с подкреплением. Реализованный таким образом алгоритм уже справляется с задачей лучше решений, полностью написанных человеком.

В этой статье мы расскажем об особенностях работы системы AutoML, а также приведем подборку книг и курсов по машинному обучению, которые помогут поближе познакомиться с технологиями искусственного интеллекта.

Когда лучше не использовать глубинное обучение

2017-10-11 в 10:53, admin, рубрики: AutoML, big data, data mining, one-shot learning, pytorch, TensorFlow, Алгоритмы, байесовский вывод, биомедицинская информатика, вероятностная нумерика, вероятностное программирование, выпуклая оптимизация, глубинное обучение, математика, машинное обучение, механистическая модель, мешок слов, нейросети, обучение с первого раза, предрассудки, размер выборки, стохастический градиент, цепь МарковаЯ понимаю, что странно начинать блог с негатива, но за последние несколько дней поднялась волна дискуссий, которая хорошо соотносится с некоторыми темами, над которыми я думал в последнее время. Всё началось с поста Джеффа Лика в блоге Simply Stats с предостережением об использовании глубинного обучения на малом размере выборки. Он утверждает, что при малом размере выборки (что часто наблюдается в биологии), линейные модели с небольшим количеством параметров работают эффективнее, чем нейросети даже с минимумом слоёв и скрытых блоков.

Далее он показывает, что очень простой линейный предиктор с десятью самыми информативными признаками работает эффективнее простой нейросети в задаче классификации нулей и единиц в наборе данных MNIST, при использовании всего около 80 образцов. Эта статья сподвигла Эндрю Бима написать опровержение, в котором правильно обученная нейросеть сумела превзойти простую линейную модель, даже на очень малом количестве образцов.

Такие споры идут на фоне того, что всё больше и больше исследователей в области биомедицинской информатики применяют глубинное обучение на различных задачах. Оправдан ли ажиотаж, или нам достаточно линейных моделей? Как всегда, здесь нет однозначного ответа. В этой статье я хочу рассмотреть случаи применения машинного обучения, где использование глубоких нейросетей вообще не имеет смысла. А также поговорить о распространённых предрассудках, которые, на мой взгляд, мешают действительно эффективно применять глубинное обучение, особенно у новичков.

Читать полностью »

Ограничения глубинного обучения и будущее

2017-08-07 в 5:48, admin, рубрики: AlphaGo, AutoML, DeepMind, python, абстракция, антропоморфизация, апокалипсис, генерация нейросетей, глубинное обучение, градиентный спуск, ИИ, машинное обучение, нейросеть, обобщения, обратное распространение, Программирование, программный синтез, разум, рассуждения, сильный ИИ, Сингулярность, функция потерь Эта статья представляет собой адаптацию разделов 2 и 3 из главы 9 моей книги «Глубинное обучение с Python» (Manning Publications).

Эта статья представляет собой адаптацию разделов 2 и 3 из главы 9 моей книги «Глубинное обучение с Python» (Manning Publications).

Статья рассчитана на людей, у которых уже есть значительный опыт работы с глубинным обучением (например, тех, кто уже прочитал главы 1-8 этой книги). Предполагается наличие большого количества знаний.

Ограничения глубинного обучения

Глубинное обучение: геометрический вид

Самая удивительная вещь в глубинном обучении — то, насколько оно простое. Десять лет назад никто не мог представить, каких потрясающих результатов мы достигнем в проблемах машинного восприятия, используя простые параметрические модели, обученные с градиентным спуском. Теперь выходит, что нужны всего лишь достаточно большие параметрические модели, обученные на достаточно большом количестве образцов. Как сказал однажды Фейнман о Вселенной: «Она не сложная, её просто много».

Читать полностью »