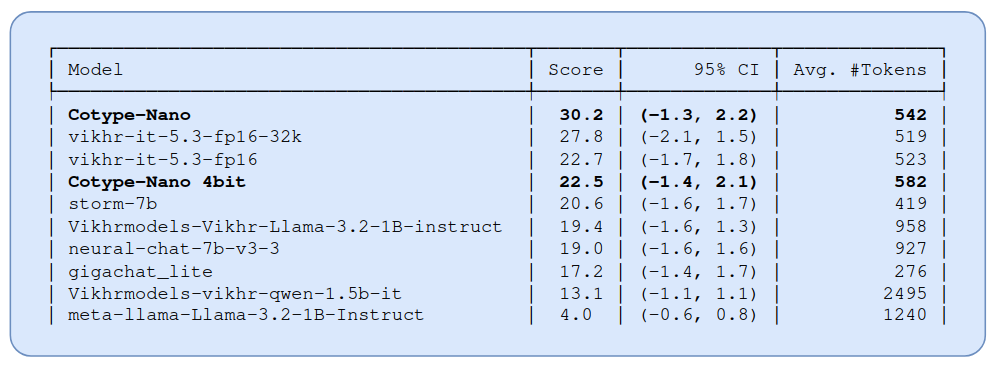

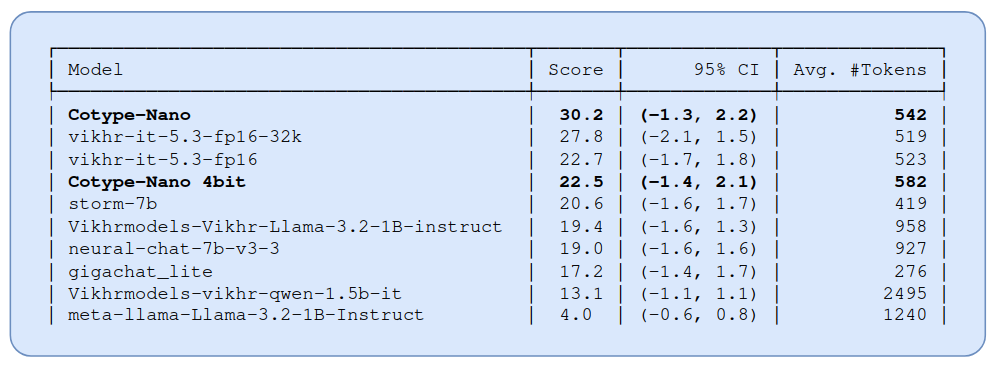

На связи группа фундаментальных исследований MTS AI. В этой статье мы расскажем про дроп трех маленьких моделей Cotype-Nano, Cotype-Nano-4bit и Cotype-Nano-CPU. Расскажем, как нам удалось достичь 1 места на RuGeneralArena в своей весовой категории.

На связи группа фундаментальных исследований MTS AI. В этой статье мы расскажем про дроп трех маленьких моделей Cotype-Nano, Cotype-Nano-4bit и Cotype-Nano-CPU. Расскажем, как нам удалось достичь 1 места на RuGeneralArena в своей весовой категории.

Все началось осенью 2017 года, тогда у нас уже был опыт разработки веб-приложений. Искали проект, удовлетворяющий следующим условиям:

Можно сделать небольшой командой.

Проверенная идея и большой потенциал роста.

Понимание как сделать лучше.

Оптимальное время разработки и выход на самоокупаемость.

Отсутствие проблем с правообладателями и законом.

Остановились на выборе проекта по созданию контекстного переводчика, потому что в тот момент он подходил нам по всем параметрам:

Команда у нас тогда уже была.

Для того, чтобы распознавать естественную человеческую речь, используют специальные модели — языковые. Они умеют воспринимать содержание текста, продолжать предложения и вести осмысленный диалог.

Вместе с дата-сайентистом и биоинформатиком Марией Дьяковой подготовили подробный гайд о том, как устроены самые популярные языковые модели и что нужно знать, чтобы начать с ними работать.

Основой семантического поиска может являться ML задача Sentence Similarity, а если быть еще конкретнее, то это Semantic Textual Similarity. Модели, обученные под эту задачу, способны оценивать насколько близки предложения по своему смыслу. Всё, что нам дальше остается, так это засунуть модель в некоторую поисковую систему, но тут давайте по порядку.

RuGPT3 - коллекция генеративных моделей от Сбер

Проводим автоматическое тестирование циклическим перебором вариантов

Работаем в Colab, тестируем Small, Mediub, Large.

Параметры генерации совершенно неоптимизированы - это первый заход, чтобы посмотреть исходную ситуацию и сравнивать по мере улучшения.

Читать полностью »

Привет. Прошло уже почти полгода как я сделал новостной агрегатор каналов в Телеграме с открытым исходным кодом. Краткую статью про него можно прочитать на VC. Здесь же я бы хотел поделиться некоторыми интересными вещами, которые я нашёл в данных за всё время работы агрегатора.

Привет. Я последние пару лет играюсь с естественной речью на русском языке. Решил поделиться своим опытом по работе с поэзией. Будет две статьи: вот эта и про рифму (когда дойдут руки всё доделать).

Половина программистов, прочитав заголовок, скорее всего подумала, что задача очень простая: сравнить две маски. Но есть нюансы, которые сильно влияют на результат, и о них то я и расскажу.

Речь пойдёт о так называемом силлабо-тоническом стихосложенииЧитать полностью »

NLI (natural language inference) – это задача автоматического определения логической связи между текстами. Обычно она формулируется так: для двух утверждений A и B надо выяснить, следует ли B из A. Эта задача сложная, потому что она требует хорошо понимать смысл текстов. Эта задача полезная, потому что "понимательную" способность модели можно эксплуатировать для прикладных задач типа классификации текстов. Иногда такая классификация неплохо работает даже без обучающей выборки!

До сих пор в открытом доступе не было нейросетей, специализированных на задаче NLI для русского языка, но теперь я обучил целых три: Читать полностью »

TL;DR: перевод поста Chaitanya Joshi "Transformers are Graph Neural Networks": схемы, формулы, идеи, важные ссылки. Публикуется с любезного разрешения автора.

Друзья-датасаентисты часто задают один и тот же вопрос: графовые нейронные сети (Graph Neural Networks) — прекрасная идея, но были ли у них хоть какие-то настоящие истории успеха? Есть ли у них какие-нибудь полезные на практике приложения?

Можно привести в пример и без того известные варианты — рекомендательные системы в Pinterest, Alibaba и Twitter. Но есть и более хитрая история успеха: штурмом взявшая промышленную обработку естественного языка архитектура Transformer.

В этом посте мне бы хотелось установить связи между графовыми нейронными сетями и трансформерами (Transformers). Мы поговорим об интуитивном обосновании архитектур моделей в NLP- и GNN-сообществах, покажем их связь на языке формул и уравнений и порассуждаем, как оба "мира" могут объединить усилия, чтобы продвинуть прогресс.