В конце зимы этого года прошло соревнование IEEE's Signal Processing Society — Camera Model Identification. Я участвовал в этом командном соревновании в качестве ментора. Об альтернативном способе формирования команды, решении и втором этапе под катом

Читать полностью »

Рубрика «kaggle» - 4

kaggle: IEEE’s Camera Model Identification

2018-07-05 в 11:05, admin, рубрики: computer science, computer vision, image processing, kaggle, python, Блог компании Open Data Science, машинное обучение, обработка изображений, управление разработкойШкола Данных: как совместить математику и бизнес

2018-06-26 в 4:44, admin, рубрики: big data, data mining, kaggle, sna, Алгоритмы, алгоритмы обработки данных, анализ данных, анализ социальных сетей, Блог компании Школа Данных, искусственный интеллект, математика, машинное обучение, рекомендательные системы, школа данных

Что мешает успешно совместить математику и бизнес?

Этот текст — первая из серии статей о том, как корректно встроить инструменты big data с выгодой для бизнеса.

Маленький спойлер: все получится, если помнить о самом бизнесе.

Еще 5 лет назад крупные компании хотели внедрить у себя новомодную “бигдату”. Но настоящих экспериментаторов было мало. Исключениями стали те, кто точно обладал массой данных: телеком, банковский сектор, интернет-компании. А в 2018 году за экспертизой в больших данных бизнесы приходят сами, причем из самых неожиданных отраслей: металлургия, страхование, авиаиндустрия.Читать полностью »

Выявление и классификация токсичных комментариев. Лекция в Яндексе

2018-06-24 в 10:54, admin, рубрики: kaggle, Блог компании Яндекс, конкурсы, конкурсы разработчиков, машинное обучение, модерация, Спортивное программирование, токсичностьВо всех современных системах модерации используется либо краудсорсинг, либо уже ставшее классикой машинное обучение. На очередной тренировке по ML в Яндексе Константин Котик, Игорь Галицкий и Алексей Носков рассказали о своём участии в конкурсе по массовому выявлению оскорбительных комментариев. Конкурс проходил на платформе Kaggle.

— Всем привет! Меня зовут Константин Котик, я data scientist в компании «Кнопка жизни», студент физфака и Высшей школы бизнеса МГУ.

Читать полностью »

iMaterialist Furniture Challenge или 50 оттенков стульев

2018-06-22 в 8:51, admin, рубрики: computer vision, kaggle, keras, neural networks, python, Алгоритмы, искусственный интеллект, классификация изображений, машинное обучение, нейронные сети, Спортивное программированиеНедавно на Kaggle закончилось соревнование iMaterialist Challenge (Furniture), задачей в котором было классифицировать изображения на 128 видов мебели и предметов быта (так называемая fine-grained classification, где классы очень близки друг к другу).

В этой статье я опишу подход, который принес нам с m0rtido третье место, но прежде, чем переходить к сути, предлагаю воспользоваться для решения этой задачи естественной нейросетью в голове и разделить стулья на фото ниже на три класса.

Соревнование Kaggle Home Credit Default Risk — анализ данных и простые предсказательные модели

2018-06-19 в 20:12, admin, рубрики: big data, data mining, kaggle, LightGBM, python, scikit-learn, машинное обучение, переводНа датафесте 2 в Минске Владимир Игловиков, инженер по машинному зрению в Lyft, совершенно замечательно объяснил, что лучший способ научиться Data Science — это участвовать в соревнованиях, запускать чужие решения, комбинировать их, добиваться результата и показывать свою работу. Собственно в рамках этой парадигмы я и решил посмотреть внимательнее на соревнование по оценке кредитного риска от Home Credit и объяснить (начинающим дата саентистам и прежде всего самому себе), как правильно анализировать подобные датасеты и строить под них модели.

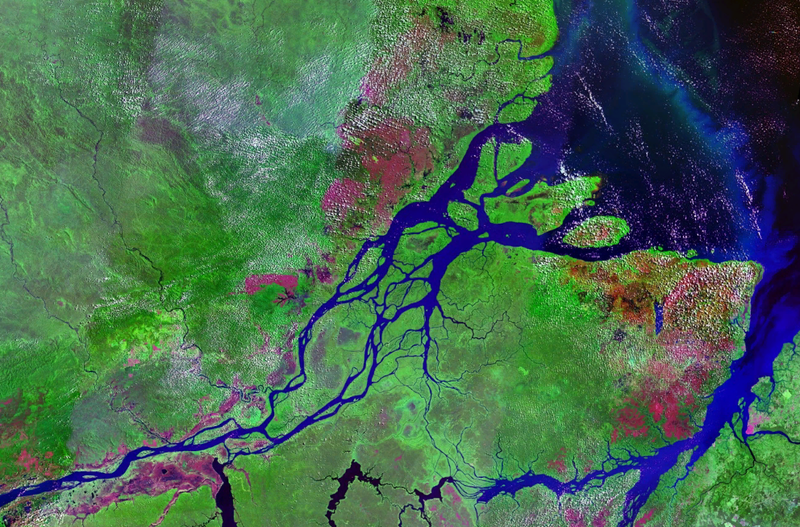

Kaggle: Amazon from Space — трюки и хаки при обучении нейросетей

2018-06-14 в 11:01, admin, рубрики: computer vision, kaggle, machine learning, python, Алгоритмы, Блог компании Open Data Science, машинное обучение, обработка изображений

Летом прошлого года закончилось соревнование на площадке kaggle, которое было посвящено классификации спутниковых снимков лесов Амазонки. Наша команда заняла 7 место из 900+ участников. Не смотря на то, что соревнование закончилось давно, почти все приемы нашего решения применимы до сих пор, причём не только для соревнований, но и для обучения нейросетей для прода. За подробностями под кат.

Читать полностью »

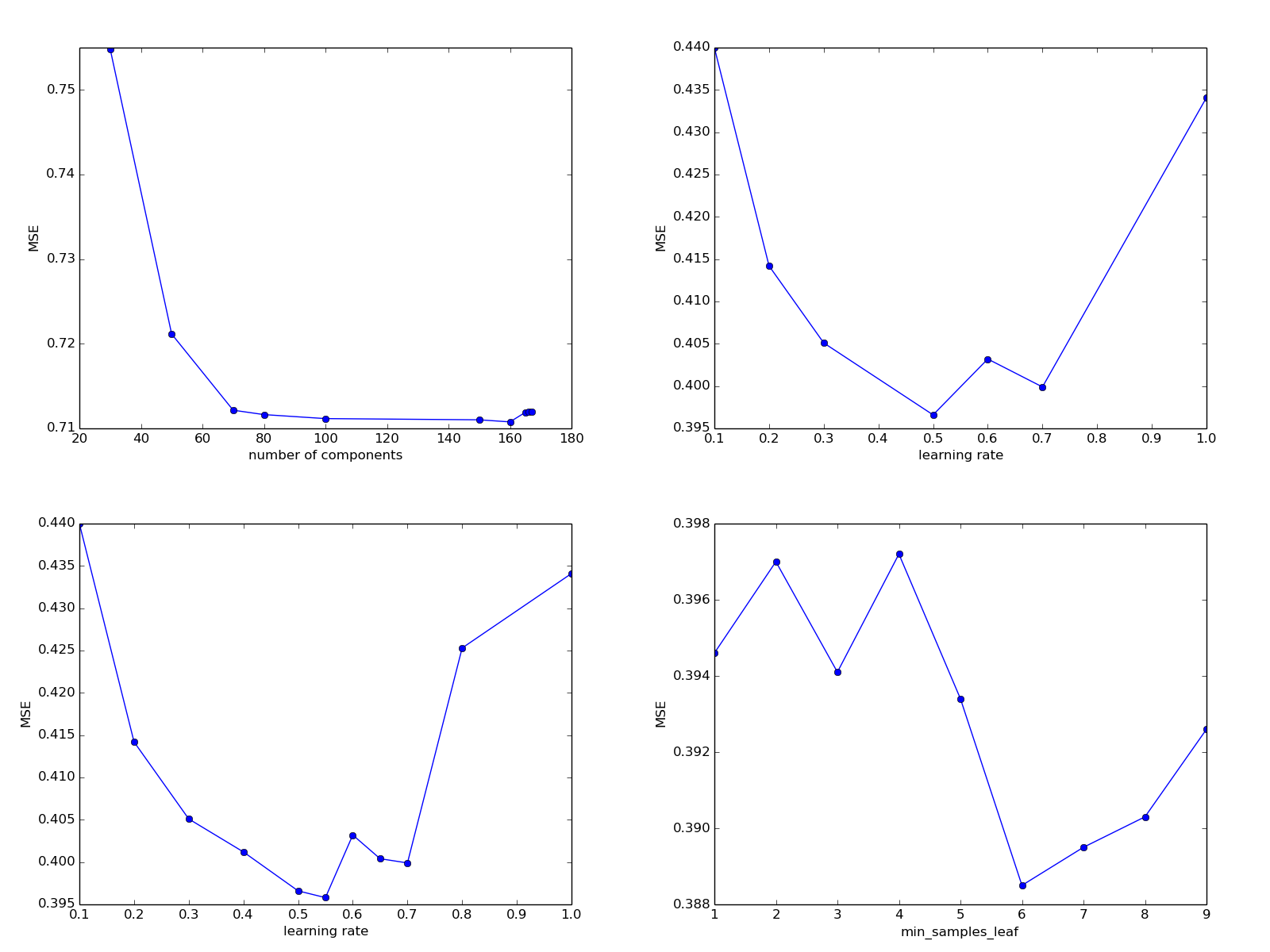

Настройка модели машинного обучения: подбор фичей и оптимизация гиперпараметров

2018-05-01 в 12:03, admin, рубрики: data mining, kaggle, machine learning, python, Алгоритмы, математика, машинное обучениеВведение

В предыдущей статье цикла мы обсудили постановку задачи анализа данных, сделали первые шаги в настройке модели машинного обучения и написали интерфейс, удобный для использования прикладным программистом. Сегодня мы проведем дальнейшее исследование задачи — поэкспериментируем с новыми фичами, попробуем более сложные модели и варианты их настроечных параметров.

В статье, насколько возможно, используется русскоязычная терминология, выбранная автором на основе буквальных переводов англоязычных терминов и устоявшегося в сообществе сленга. О ней можно почитать здесь.

Читать полностью »

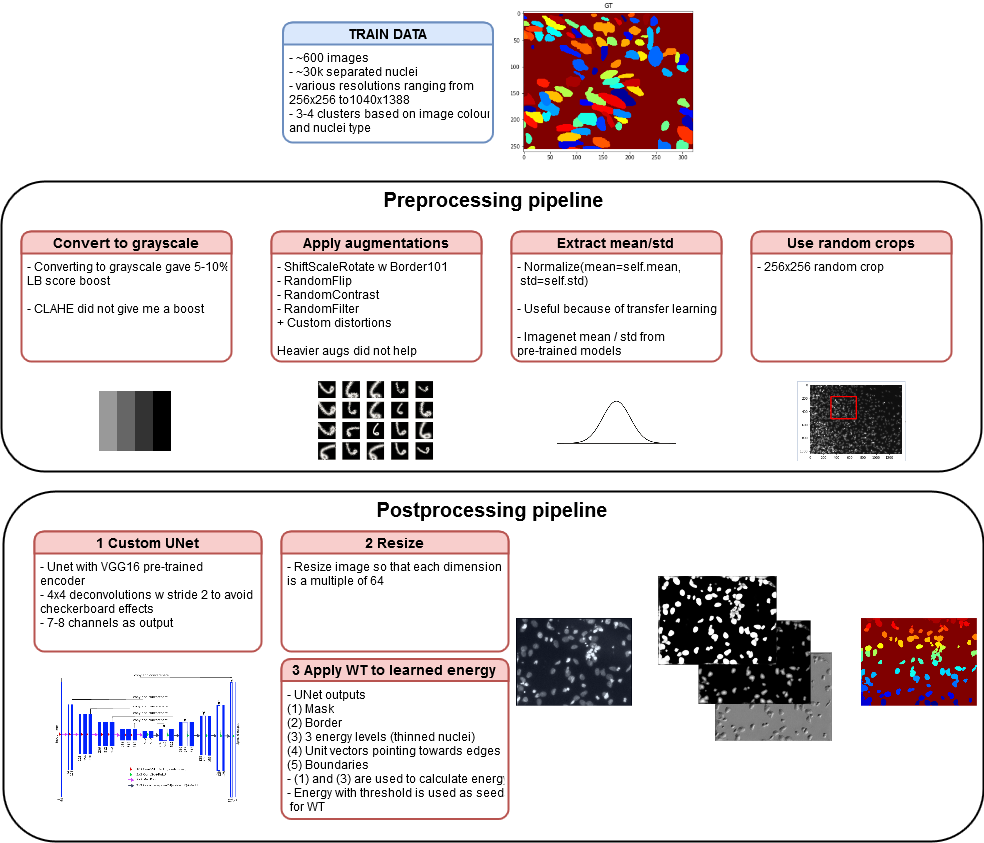

Применяем Deep Watershed Transform в соревновании Kaggle Data Science Bowl 2018

2018-04-22 в 14:55, admin, рубрики: data mining, kaggle, neural networks, python, pytorch, машинное обучение, обработка изображений, перевод с английскогоПрименяем Deep Watershed Transform в соревновании Kaggle Data Science Bowl 2018

Представляем вам перевод статьи по ссылке и оригинальный докеризированный код. Данное решение позволяет попасть примерно в топ-100 на приватном лидерборде на втором этапе конкурса среди общего числа участников в районе нескольких тысяч, используя только одну модель на одном фолде без ансамблей и без дополнительного пост-процессинга. С учетом нестабильности целевой метрики на соревновании, я полагаю, что добавление нескольких описанных ниже фишек в принципе может также сильно улучшить и этот результат, если вы захотите использовать подобное решение для своих задач.

описание пайплайна решения

Автоматическая векторизация спутниковых снимков: одна модель — два первых места

2018-03-22 в 11:00, admin, рубрики: deep learning, image processing, kaggle, neural networks, python, satellite imaging, segmentation, Topcoder, Алгоритмы, Блог компании Open Data Science, машинное обучение, обработка изображений

Всем привет!

В данной статье хочу поделиться с вами историей о том, как одна и та же архитектура модели принесла сразу две победы в соревновательном машинном обучении на платформе topcoder с интервалом месяц.

Речь пойдёт о следующих соревнованиях:

- Urban 3d mapper — поиск домиков на спутниковых снимках. Соревнование длилось 2 месяца, было 54 участников и пять призовых мест.

- Spacenet: road detection challenge — поиск графа дорог. На решение также давалось 2 месяца, включало 33 участника и пять призовых позиций.

В статье рассказывается об общих подходах к решению таких задач и особенностях реализации для конкретных конкурсов.

Для комфортного чтения статьи желательно обладать базовыми знаниями о свёрточных нейронных сетях и их обучении.

Как быстро написать и выкатить в продакшн алгоритм машинного обучения

2018-03-13 в 10:06, admin, рубрики: big data, data mining, data science, kaggle, machine learning, python, машинное обучениеСейчас анализ данных все шире используется в самых разных, зачастую далеких от ИТ, областях и задачи, стоящие перед специалистом на ранних этапах проекта радикально отличаются от тех, с которыми сталкиваются крупные компании с развитыми отделами аналитики. В этой статье я расскажу о том, как быстро сделать полезный прототип и подготовить простой API для его использования прикладным программистом.

Для примера рассмотрим задачу предсказания цены на трубы размещенную на платформе для соревнований Kaggle. Описание и данные можно найти здесь. На самом деле на практике очень часто встречаются задачи в которых надо быстро сделать прототип имея очень небольшое количество данных, а то и вообще не имея реальных данных до момента первого внедрения. В этих случаях приходится подходить к задаче творчески, начинать с несложных эвристик и ценить каждый запрос или размеченный объект. Но в нашей модельной ситуации таких проблем, к счастью, нет и поэтому мы можем сразу начать с обзора данных, определения задачи и попыток применения алгоритмов.

Читать полностью »