Нигде, наверно, нет такой насущной необходимости в синергии знаний разных областей науки — как в области машинного обучения и Deep Learning. Достаточно открыть капот TensorFlow и ужаснуться — огромное количество кода на python, работающее с тензорами внутри… C++, вперемешку с numpy, для выкладки в продакшн требующее чуток покодить «на плюсах», вприкуску с bazel (это так волнует, всю жизнь мечтал об этом!). И другая крайность — ребята из Deeplearning4j прокляли python к чертовой матери и вращают тензоры на старой и доброй java. Но дальше всех ушли, похоже, студенты из университета Нью-Йорка — люди, причем не только студенты, причем давно и серьезно жгут на Luajit + nginx (аминь по католически). Ситуация осложняется недавним демаршем Google DeepMind в отношении «дедушки torch»: все проекты переводят на свой внутренний движок, родившийся из DistBelief.

Полнейший хаос и бардак.

Читать полностью »

Рубрика «BigData» - 8

Deep Learning — что же делать, кого бить

2016-08-03 в 17:08, admin, рубрики: big data, BigData, deep learning, машинное обучениеНейронные сети на Javascript

2016-07-01 в 8:18, admin, рубрики: big data, BigData, canvas, javascript, mnist, node.js, nodejs, машинное обучение, нейронные сети

Идея для написания этой статьи возникла прошлым летом, когда я слушал доклад на конференции BigData по нейронным сетям. Лектор «посыпал» слушателей непривычными словечками «нейрон», «обучающая выборка», «тренировать модель»… «Ничего не понял — пора в менеджеры», — подумал я. Но недавно тема нейронных сетей все же коснулась моей работы и я решил на простом примере показать, как использовать этот инструмент на языке JavaScript.

Мы создадим нейронную сеть, с помощью которой будем распознавать ручное написание цифры от 0 до 9. Рабочий пример займет несколько строк. Код будет понятен даже тем программистам, которые не имели дело с нейронными сетями ранее. Как это все работает, можно будет посмотреть прямо в браузере.

Читать полностью »

Смотрите записи докладов виртуального форума «Данные. Технологии. SQL Server 2016»

2016-06-23 в 6:53, admin, рубрики: azure, azure ml, BigData, IoT, microsoft, Microsoft Azure, Microsoft SQL Server, Power BI, R, rdbms, sql, sql server, sql server 2016, Блог компании Microsoft, виртуальны форумДоступны записи докладов форума в высоком качестве на Channel9. Программа форума была разделена на 3 трека, см. описание ниже, доклады из каждого трека доступны по ссылке channel9.msdn.com/Events/data-platform-russia/Virtual-Forum-data-technologies-SQL-Server-2016

SQL Server 2016: новые стандарты в мире OLTP. Трек посвящен возможностям новой платформы по повышению производительности и безопасности процессов. Так, скорость обработки транзакций на новой платформе выше в 30 раз, а запросов – в 100 раз, по сравнению с дисковыми реляционными базами. Безопасность системы обеспечивается современными инструментами Always Encrypted и Role Level Security.

Бизнес-аналитика: SQL, Power BI, R, Mobile. Обсуждение вариантов практического применения SQL Server 2016 для разработки интеллектуальных приложений, способных анализировать данные и организовывать их в умные системы с помощью технологий бизнес-аналитики BI, а также использования языка R.

Azure: новое поколение решений для аналитики, Big Data& IoT. Доклады об обеспечении автоматизации критически-важных процессов в компании благодаря умным аналитическим системам, машинному обучению и ботам, а также интеграции в облако с возможностью масштабирования ИТ-инфраструктуры.

Читать полностью »

Примите участие в виртуальном форуме «Данные. Технологии. SQL Server 2016»

2016-06-01 в 7:03, admin, рубрики: azure, azure ml, BigData, IoT, microsoft, Microsoft Azure, Microsoft SQL Server, Power BI, R, rdbms, sql, sql server, sql server 2016, Блог компании Microsoft, виртуальны форумОдин самых значимых трендов ближайшего десятилетия – лавинообразный рост объемов данных, который определяет развитие облачных технологий, машинного обучения и интернета вещей. Это требует новых подходов и решений в устоявшихся и широко известных технологиях, таких как реляционные базы данных и бизнес-аналитика.

Читать полностью »

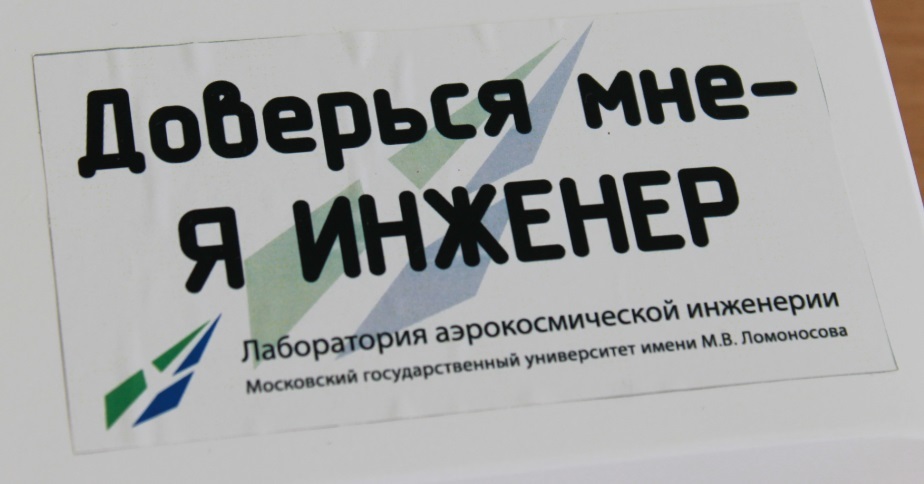

Всероссийская инженерная олимпиада для старшеклассников: BigData и Интеллектуальные энергетические системы

2016-05-28 в 18:11, admin, рубрики: "Всегда готов!", big data, BigData, rusventure, ВДЦ "Орленок", Занимательные задачки, математика, машинное обучение, Олимпиада НТИ, олимпиады, Промышленное программирование, рвк

— Вовочка, бросай свои эксперименты с холодным ядерным синтезом, иди к ЕГЭ готовься.

— Ща, мам.

Олимпиады — это круто. Они позволили такому раздолбаю свободолюбивому и умном, как я, поступить в университет без экзаменов.

Помню пришли мы в приемную комиссию с приятелем, в шортах и с рюкзаками, в которых были полотенца и волейбольный мяч, заполнили анкеты, выложили по пачке дипломов с олимпиад и поехали на море.

— Что вы сегодня на час опоздали?

— Да так, в универ поступали.

Я очень рад, что нашлись инициативные ребята, которым не все равно, что талантливый школьник-инженер тратит свои последние беззаботные годы, судорожно готовясь к сдачи ЕГЭ, вместо того, чтобы строить реактивные ранцы или программировать зародыш искусственного интеллекта.

Чтобы создать лазейку для молодых талантливых инженеров, они придумали следующую штуковину — давайте замутим инженерную олимпиаду, которая дает возможность поступить в вуз.

Недавно в ВДЦ «Орленок» прошел «тест-драйв» Всероссийской инженерной олимпиады. Участвовали 5000 детей со всей России, до финала дошли около 100 человек. Призов много, но самое полезное — по +10 очков к ЕГЭ.

Я за всем присматривал и готов поделиться своими впечатлениями.

Олимпиада шла по четырем профилям.

- Большие данные и машинное обучение.

- Интеллектуальные энергетические системы.

- Космические системы.

- Автономные транспортные системы.

Про первые два профиля расскажу здесь (чуток задач и фоток), про вторые два — немного попозже на GT.

Читать полностью »

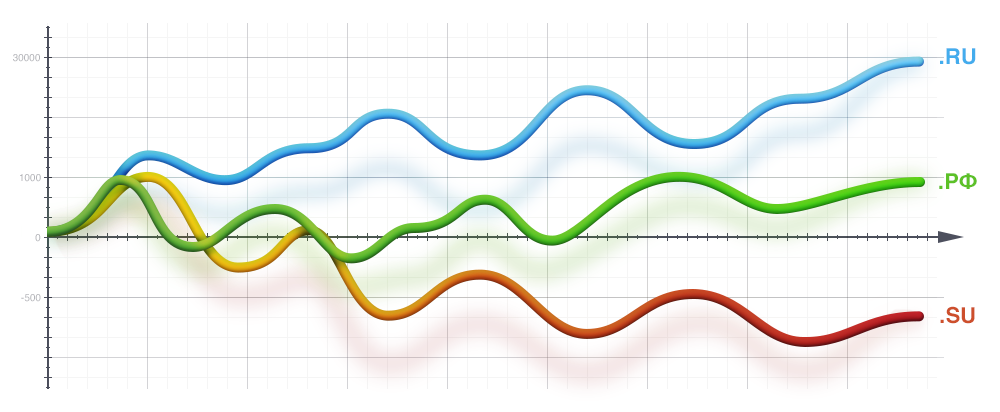

Статистика распределения доменов по AS, IP, NS, MX и прочим параметрам

2016-05-27 в 12:53, admin, рубрики: BigData, firststat.ru, mysql, open source, python, statistics, Занимательные задачки, параллельное программированиеДавным-давно перестал работать 1stat.ru — откровенно говоря, для нас это была трагедия (сейчас вроде он как-то работает).

Рабочий день обычно начинался с чашечки кофе и приятного просмотра значений прироста доменов. Конечно же, такие метрики не показывают ни успешность компании, ни ее капитализацию, ни тип клиентов, которые размещаются у компании. Но, несмотря на это, косвенно можно оценить динамику роста или деградации компании — если количество доменов на NS серверах растет, а не падает — это хорошо. Как показала практика, это, так или иначе, отражает положение дел на рынке.

EMC делает ставку на ReactOS для хранения больших данных в IoT-сфере

2016-03-31 в 21:55, admin, рубрики: 32 марта, BigData, btrfs, EMC, ext2, ext3, ext4, ffs, file systems, IoT, ntfs, open source, reactos, reiserfs, Uniata, Блог компании Фонд ReactOS, Разработка для интернета вещей, разработка под windows, хранение данных, метки: file systemsПриветствуем Хабр!

Спешим продолжить неделю хороших новостей из мира Opensource! Праздник на улице адептов открытого ПО продолжается.

Вы должно быть заметили, что с недавних пор в ReactOS ведется серьезная работа над поддержкой различных файловых систем. На текущий момент поддерживается Ext234, NTFS на чтение (уже готовится патч «на запись»), BTRFS, ReiserFS и FFS готовят к включению. Активно обновляется универсальный драйвер ATA-устройств — UniATA. Все это оживление произошло неспроста.

Дело в том, что мы уже длительное время вели переговоры с корпорацией EMC о возможном сотрудничестве и прилагали все усилия, чтобы доказать наличие скрытого потенциала роста в нашем проекте. В вот наконец было достигнуто принципиальное соглашение о том, что EMC возьмет проект ReactOS под патронаж. Нет, ни о какой потере самостоятельности речь не идет, а только целенаправленном о стимулировании разработки, свободное ПО должно оставаться свободным. Просто в корпорации вслед за примером лидеров в других секторах рынка программного обеспечения с новой силой уверовали в силу открытого ПО и решили не отставать от новейших тенденций.

Читать полностью »

AI, BigData & HPC Digest #4

2016-02-06 в 13:24, admin, рубрики: AI, big data, BigData, data mining, FlyElephant, high performance computing, HPC, R, анализ данных, Блог компании FlyElephant, Большие данные, видео, высокая производительность, дайджест, искусственный интеллект, Мероприятия, Новости, подкасты, статьи

Команда FlyElephant подготовила для Вас новый дайджест, включающий в себя подборку ссылок на интересные материалы по направлениям: искусственный интеллект, большие данные и высокопроизводительные вычисления.

Читать полностью »

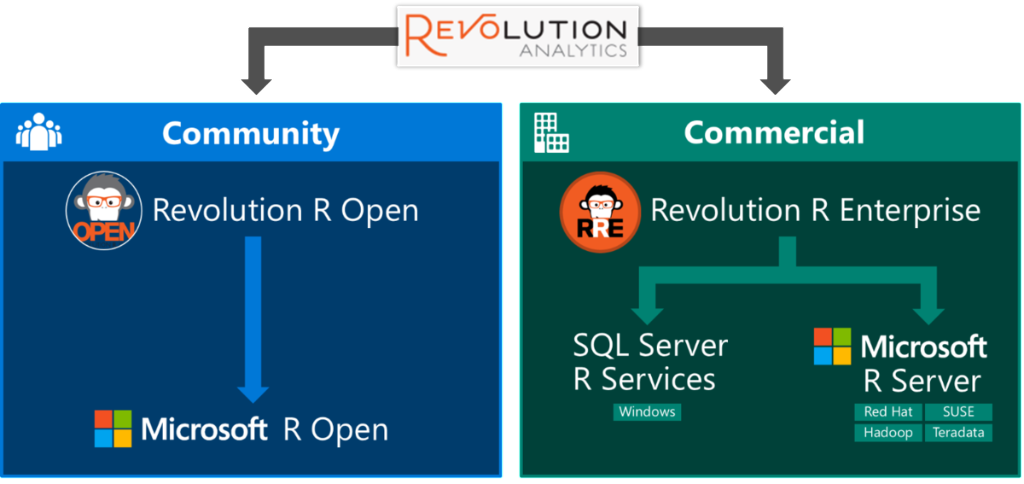

Revolution R переименован в Microsoft R и доступен бесплатно для разработчиков и студентов

2016-01-14 в 12:38, admin, рубрики: big data, BigData, microsoft, Microsoft SQL Server, R, sqlserver

За девять месяцев, с тех пор как Microsoft приобрела Revolution Analytics, компанией было выпущено много обновлений для Revolution R Open и Revolution R Enterprise, не говоря уже об интеграции R с SQL Server, PowerBI, Azure и Cortana Analytics.

Несколько дней назад, Microsoft предоставила доступ к продуктам R Server по подпискам MSDN и DreamSpark.

Читать полностью »

AI, BigData & HPC Digest #3

2015-12-30 в 12:33, admin, рубрики: AI, big data, BigData, data mining, FlyElephant, high performance computing, HPC, R, анализ данных, Блог компании FlyElephant, Большие данные, видео, высокая производительность, дайджест, искусственный интеллект, Мероприятия, Новости, подкасты, статьи

Привет!

Наша команда FlyElephant хочет поздравить всех с наступающим Новым Годом, пожелать всего самого лучшего и успешной реализации всех задуманных проектов в предстоящем году, а чтобы на выходных было что почитать, публикуем свежий номер дайджеста. Сегодня в выпуске традиционная подборка интересных ссылок на новости и материалы по направлениям: искусственный интеллект, большие данные и высокопроизводительные вычисления.

14-го января мы проведем вебинар на тему "Введение в машинное обучение", на котором поговорим об истории и основных понятиях машинного обучения. Рассмотрим популярные задачи/алгоритмы машинного обучения, а также запустим их примеры при помощи платформы FlyElephant и узнаем как возможно использовать данную платформу для решения задач искусственного интеллекта. Зарегистрироваться на вебинар можно здесь.

Читать полностью »