Метка «цод» - 3

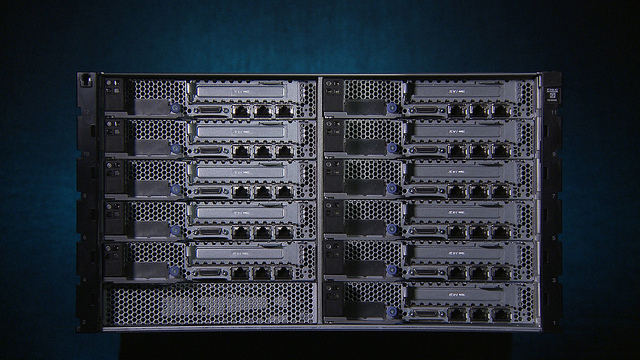

IBM представляет NeXtScale System – высокопроизводительную вычислительную платформу для ЦОД

2013-09-12 в 7:07, admin, рубрики: IBM, Блог компании IBM, высокая производительность, высокие нагрузки, сервер, цод, метки: IBM, высокие нагрузки, сервер, цодОсобенности эксплуатации систем кондиционирования в летний период времени

2013-09-12 в 4:17, admin, рубрики: Блог компании «Медиа Грус», журнал, ит-инфраструктура, кондиционирование, хостинг, цод, ЦОДы.РФ, метки: журнал, кондиционирование, цод, ЦОДы.РФ

Проблем с эксплуатацией правильно спроектированных, смонтированных в соответствии с проектом и грамотно обслуживаемых систем кондиционирования в летний период быть не должно, так же как не должно быть каких-то серьёзных особенностей при их эксплуатации.

Но я не зря сразу оговорился: «правильно спроектированных, смонтированных и обслуживаемых», так как все эти операции выполняют люди, которым, увы, свойственно делать ошибки…

Ошибки проектирования, как это ни печально, встречаются довольно часто. Наиболее часто встречающейся ошибкой проектирования является неправильно выбранная температура окружающего воздуха для расчёта холодильных агрегатов (воздухоохлаждаемых градирен или конденсаторов). Зачастую проектировщики при подборе оборудования принимают за расчётную максимальную температуру, указанную в каталоге производителя, т. е. +35 °С. Сколько заказчиков попалось в этот капкан в пиковые жаркие дни! По факту температура окружающего воздуха вокруг установленного холодильного оборудования на кровле с мягкой гидроизоляцией черного цвета достигает свыше +40 °С, в тени при уличной температуре — +35 °С. Что же происходит с холодильным оборудование при таких превышениях расчетных условий? В лучшем случае понизится холодопроизводительность каждого холодильного контура. В худшем — как только мы достигнем граничного значения давления встроенной защиты, компрессоры холодильных контуров начнут отключаться, и вся система остановится до момента снижения давления в ней. Причем невозможно заранее предугадать или точно рассчитать, при какой температуре окружающего воздуха произойдет превышение значения аварийного давления в компрессоре.

Читать полностью »

Дата-центр NORD на Коровинском шоссе

2013-09-11 в 7:52, admin, рубрики: dataline, Блог компании DataLine, дата-центр, ДГУ, ИБП, ит-аутсорсинг, ит-инфраструктура, колокейшн, кондиционирование, цод, метки: dataline, дата-центр, ДГУ, ИБП, ит-аутсорсинг, ит-инфраструктура, колокейшн, кондиционирование, цод Знакомьтесь, это дата-центр NORD на Коровинском шоссе.

ЦОД состоит из трех корпусов (NORD 1, NORD 2, NORD 3) и на сегодняшний день является самым масштабным объектом компании DataLine. Общая площадь всех корпусов дата-центров NORD 7636 кв. м., на таких пространствах с легкостью разместятся 1280 стоек в 8 машинных залах.

Панорамный вид на локацию NORD: NORD 2 (серый) и NORD 1, тот, что у серого под боком. Общая площадь NORD 2 — 1713 кв. м, количество стойко-мест — 474. Общая площадь NORD 1 — 1320 кв. м, количество стойко-мест – 284. А серый корпус в стороне – это NORD 3, который был запущен в этом году. Общая площадь — 1880 кв. м, количество стойко-мест — 450. Там же, где котлован (сейчас уже залит фундамент), строится новый корпус NORD 4 общей площадью 11700 кв. м и на 2000 стоек. Запуск первых машинных залов NORD 4 запланирован на первую половину 2014 года.

Читать полностью »

Про InfiniBand: как мы уменьшали пинг с 7 мкс до 2,4 мкс (и результаты тестов)

2013-08-26 в 9:59, admin, рубрики: Cisco, ethernet, infiniband, intel, sla, архитектура, Блог компании КРОК, высокая производительность, ит-инфраструктура, тесты, цод, метки: Cisco, ethernet, infiniband, intel, sla, архитектура, высокая производительность, ИБ, тесты, цод .jpg)

InfiniBand-свитч SX6005. 12 FDR 56Gb/s портов на одном юните, коммутация 1.3Тб/с.

Многие считают, что InfiniBand — это «космос». То есть считается, что дорого и нужно только для «суперкомпьютеров» (HPC) производительностью в 1-2 Петафлопа и с гиганскими объмами обрабатываемых данных. Тем не менее, с помощью этой технологии можно организовывать не только самые скоростные межсистемные соединения в кластерах, но и радикально снижать задержки в работе критичных приложений. Конкретно – делать то, что может решаться и с помощью Ethernet, но экономичнее и быстрее. Вот пример.

Задача

У одного нашего крупного заказчика из финансовой сферы была проблема в скорости работы двух приложений. Специфика приложений заключалась в том, что необходимо было обрабатывать большое количество транзакций с минимальной задержкой. 6-7 мкс latency – это лучшие результаты, которые они достигли путем апгрейда серверов и максимальной софтверной доработкой. Дальнейшие возможные оптимизации сулили улучшения на уровне 0,3-0,5 мкс. Мы же пришли и сообщили, что сможем уменьшить задержки в два раза. Читать полностью »

Риски ЦОД: резервирование инженерных систем

2013-08-19 в 8:35, admin, рубрики: Блог компании Группа Компаний ХОСТ, дата-центр, инженерные системы, ит-инфраструктура, надежность, отказоустойчивость, резервирование, цод, Энергия и элементы питания, метки: дата-центр, инженерные системы, надежность, отказоустойчивость, резервирование, цод Начинать чинить надо, пока не сломалось — сломанное поддаётся ремонту гораздо неохотней.

Юрий Татаркин

После того как обеспечены надежные стены и крыша над головой для ЦОД (статья «Риски ЦОД: выбираем месторасположение»), следующим шагом на пути обеспечения его отказоустойчивости должно стать резервирование инженерных систем. Строя дата-центры более 10 лет, мы убедились, что не все заказчики в полной мере осознают важность дублирования основных коммуникаций. Космические корабли и те падают, а оборудование в ЦОД в идеале должно работать 365 дней в году и 24 часа в сутки. Любая вышедшая из строя или нуждающаяся в профилактике деталь должна быть заменена без остановки работы всех критичных сервисов.

После того как обеспечены надежные стены и крыша над головой для ЦОД (статья «Риски ЦОД: выбираем месторасположение»), следующим шагом на пути обеспечения его отказоустойчивости должно стать резервирование инженерных систем. Строя дата-центры более 10 лет, мы убедились, что не все заказчики в полной мере осознают важность дублирования основных коммуникаций. Космические корабли и те падают, а оборудование в ЦОД в идеале должно работать 365 дней в году и 24 часа в сутки. Любая вышедшая из строя или нуждающаяся в профилактике деталь должна быть заменена без остановки работы всех критичных сервисов.

Как справедливо отметили наши читатели, далеко не всем компаниям нужен надежный ЦОД. Для некоторых его бесперебойная работа не предмет переживаний, а многие предпочтут хранить свои данные в публичном облаке. Данный паблик предназначен в большей степени для тех, кто по тем или иным соображениям безопасности или проходимости каналов связи сделал свой выбор в пользу собственного дата-центра и работы сервисов с уровнем доступности не менее трех девяток (простоя не более 1,6 часов в год).

HP 3PAR StoreServ

2013-08-09 в 8:13, admin, рубрики: 3par, Storeserv, Блог компании HP, Восстановление данных, переезд, резервное копирование, Серверное администрирование, СХД, цод, метки: 3par, Storeserv, переезд, резервное копирование, СХД, цодНе так давно мы говорили о системах хранения данных HP: речь шла о дисковых библиотеках и сравнении их с ленточными. Сегодня мы расскажем вам об успешном опыте безостановочного переезда со старой СХД на новую HP 3PAR StoreServ одного из российских вузов.

Риски ЦОД: выбираем месторасположение

2013-08-08 в 12:00, admin, рубрики: Блог компании Группа Компаний ХОСТ, ГК ХОСТ, ит-инфраструктура, катастрофоустойчивость, надежность, отказоустойчивость, проектирование, цод, энергоэффективность, метки: ГК ХОСТ, катастрофоустойчивость, надежность, отказоустойчивость, проектирование, цод, энергоэффективность «Избежать катастрофы может только тот, кто считает ее возможной».

В. Швебель

Мы все больше зависим от достижений прогресса: читаем почту в кинотеатрах, отмечаем места своего присутствия в foursquare. И бизнес стал не менее зависим от технических достижений. И если для нас поломка телефона становится небольшим неудобством, то для компаний выход из строя любого элемента ИТ-инфраструктуры оборачивается колоссальными убытками. Один час простоя российского банка, входящего в ТОП-100, равен стоимости автомобиля представительского класса. А теперь представьте, размер убытков и упущенную прибыль, если у корпоративного ЦОД рухнули стены или рядом с ним прорвало теплотрассу. Быстро ли запустятся там сервисы? Сколько времени потребуется для восстановления работоспособности, если нет резервного ЦОДа?

Избежать такой катастрофы можно, изначально правильно спроектировав ЦОД, обратив внимание на его месторасположение, эффективность применяемых в нем решений, энергоемкость, надежность и окупаемость.

Международная сеть провайдеронезависимых дата-центров DataHouse

2013-07-25 в 14:00, admin, рубрики: Блог компании «Медиа Грус», дата-центр, ит-инфраструктура, Телекомы, цод, ЦОДы.РФ, метки: дата-центр, цод, ЦОДы.РФ  Западный рынок дата-центров все больше поглощает идея гигантизма: количество анонсируемых по всему миру проектов гигантских по площади дата-центров растёт в геометрической прогрессии. В России, безусловно, пытаются соответствовать тренду и строят пока не самые крупные, но уже далеко не маленькие площадки. В подавляющем большинстве они находятся на территории двух столиц, а регионы по-прежнему чаще всего представлены в отрасли операторскими дата-центрами на уровне местных АТС и небольшими серверными помещениями со сплит-кондиционированием и блоками ИБП, скромно стоящими в уголке. Ключевыми игроками на региональном рынке дата-центров все также остаются операторы связи, которые предоставляют в аренду бизнесу излишки своих площадей, а сама ситуация на региональном рынке повсеместно напоминает ситуацию середины 2000-х в Москве. Аналогичные проблемы наблюдаются и в странах СНГ.

Западный рынок дата-центров все больше поглощает идея гигантизма: количество анонсируемых по всему миру проектов гигантских по площади дата-центров растёт в геометрической прогрессии. В России, безусловно, пытаются соответствовать тренду и строят пока не самые крупные, но уже далеко не маленькие площадки. В подавляющем большинстве они находятся на территории двух столиц, а регионы по-прежнему чаще всего представлены в отрасли операторскими дата-центрами на уровне местных АТС и небольшими серверными помещениями со сплит-кондиционированием и блоками ИБП, скромно стоящими в уголке. Ключевыми игроками на региональном рынке дата-центров все также остаются операторы связи, которые предоставляют в аренду бизнесу излишки своих площадей, а сама ситуация на региональном рынке повсеместно напоминает ситуацию середины 2000-х в Москве. Аналогичные проблемы наблюдаются и в странах СНГ.

Читать полностью »

ЦОДы уходят в облака

2013-07-23 в 6:31, admin, рубрики: dell, Блог компании Dell, виртуальный хостинг, высокая производительность, КРОК, облака, Облачные вычисления, цод, метки: dell, виртуальный хостинг, КРОК, облака, облачные вычисления, цод

На определённом этапе развития все крупные компании сталкиваются с задачей модернизации собственной IT-инфраструктуры. Когда производительности имеющейсяейся инфраструктуры уже не хватает, многие из руководителей больших предприятий задумываются о постройке нового собственного ЦОДа. Поиск здания, подходящего для дата-центра, подбор персонала, проектирование, монтаж базовых и дополнительных элементов ЦОДа — всё это требует большого количества времени и материальных ресурсов. Но есть и альтернатива!

Благодаря активному развитию облачных технологий и виртуализации, в России уже появились провайдеры, предоставляющие услугу «Облачный ЦОД», которая позволяет полностью перевести IT-инфраструктуру на аутсорсинг, сохранив при этом высокий уровень масштабируемости и надёжности. Стоит такая услуга недёшево, но, при взвешенном подходе, даёт возможность более рационально использовать ресурсы компании.

Так ли хорош облачный ЦОД, как его рекламируют? Правда ли, что биллинг помогает экономить, а виртуализации серверов достаточно для построения качественной облачной инфраструктуры? На эти и ряд других вопросов мы постараемся дать ответы под хабракатом.

Читать полностью »

CloudEngine. Заявка на лидерство от Huawei. Часть 1

2013-07-16 в 8:38, admin, рубрики: FCoE, huawei, TRILL, высокая производительность, Железо, Сетевое оборудование, цод, метки: FCoE, huawei, TRILL, цод Данная статья открывает серию публикаций посвященных совершенно новой линейке оборудования компании Huawei под общим названием CloudEngine, а так же технологиям и решениям, примененным в этом оборудовании.

Читать полностью »