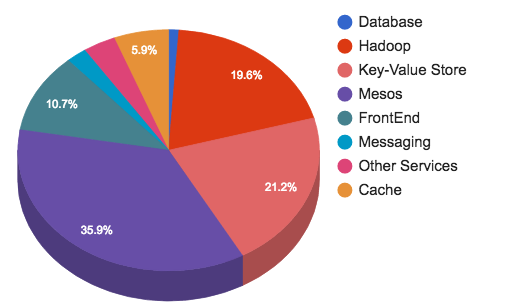

Пару недель назад, я решил взять простейший пример HTTP сервера на Go и измерить его производительность. Потом я смело взял Phoenix, прогнал на тех же тестах, и расстроился. Результаты были не в пользу Elixir/Erlang (45133 RPS у Go и всего 3065 RPS у Phoenix). Но Phoenix — это тяжело. Надо что-то хотя бы примерно равное по простоте и логике разработки тому, что есть на Go: когда есть путь — "/" и handler для него. Логичной аналогией мне показалось решение cowboy + plug, где у нас есть Router, который так же ловит "/" и отвечает на него. Результаты убили — Elixir/Erlang опять оказался медленнее:

Golang

sea@sea:~/go$ wrk -t10 -c100 -d10s http://127.0.0.1:4000/

...

452793 requests in 10.03s, 58.30MB read

Requests/sec: 45133.28

Transfer/sec: 5.81MBelixir cowboy plug

sea@sea:~/http_test$ wrk -t10 -c100 -d10s http://127.0.0.1:4000/

...

184703 requests in 10.02s, 28.57MB read

Requests/sec: 18441.79

Transfer/sec: 2.85MBКак жить дальше? Две недели я не спал и не ел (почти). Все, во что я верил все эти годы: совершенство vm erlang, ФП, зеленые процессы, было растоптано разорвано, сожжено и пущено по ветру. Немного отойдя от шока, успокоившись, и подтерев сопли я решил разобаться, в чем дело.