Интересно, как много программистов и разработчиков открыли для себя data science или data engineering, и строят успешную карьеру в области больших данных. Илья Маркин, Software engineer в Directual, — как раз один из разработчиков, перешедших в data engineering. Поговорили об опыте в роли тимлида, любимом инструменте в data engineering, Илья рассказал о конференциях и интересных профильных каналах джавистов, о Directual с пользовательской стороны и технической, о компьютерных играх и пр.

— Илья, спасибо, что нашел время встретиться. Поздравляю и с относительно недавним переходом в новую компанию, и с рождением дочки, хлопот и забот у тебя сейчас много. Сразу же первый вопрос: чем таким интересным тебе предложили заниматься в Directual, что ты ушел из DCA?

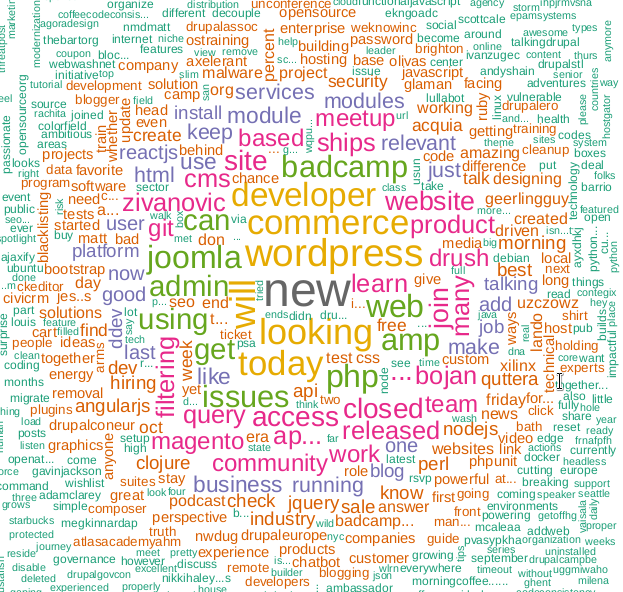

— Наверное, прежде надо рассказать, чем я в DCA занимался. В DCA (Data-Centric Alliance) я попал после прохождения программы «Специалист по большим данным». В тот момент я активно интересовался темой big data и понял, что это именно та область, в которой я хочу развиваться. Ведь там, где много данных, интересных инженерных проблем, которые необходимо решать, тоже предостаточно. Программа помогла мне довольно быстро погрузиться в экосистему мира биг дата, там я получил необходимые начальные знания о Hadoop, YARN, парадигме Map-Reduce, HBase, Spark, Flink, и многом другом, и о том, как это работает под высокой нагрузкой.

Читать полностью »