Рассматривая разные технологии хранения данных и решения, предлагаемые компанией LSI, мы немного подзабыли о практически-прикладном смысле этого всего. Зачем нужны все возрастающие скорости и емкости дисков? Одно из первых, приходящих в голову применений — это, конечно, Big Data или Большие данные. Чем же эти Большие данные отличаются от просто больших, чтоб заслужить написание с большой буквы? Обычно это называют «правило трех V».

Метка «big data» - 14

Прогноз погоды

2013-09-20 в 14:33, admin, рубрики: big data, LSI, Большие данные, данные, метки: big data, LSI, Большие данные, данныеДанные в MarkLogic Server [Part1]

2013-09-20 в 13:28, admin, рубрики: big data, data mining, nosql, XML, метки: big data, data mining, nosql, XMLMarkLogic Server – это документо-ориентированная native XML база данных. Как и в любой документо-ориентированной DB в MarkLogic Server данные можно представить как файлово-фолдерную структуру. Кстати, при доступе к хранилищу через WebDAV данные именно так и представляются. Помимо собственно XML в MarkLogic Server можно хранить и любые бинарные данные в виде файлов.

Внутренне представление XML данных в MarkLogic Server довольно сложное и будет рассмотрено позже. Сейчас же стоит сказать о том, что поместить в MarkLogic Server можно только well formed XML так как хранится он не в виде простого текста, а как объект данных типа XML. Кодировкой внутреннего представления XML данных является Unicode, что избавляет от множества проблем с разными языками. Все Entity в XML данных разворачиваются в цифровые еntity. Если в документе используются только они, то это не доставит никаких проблем, в противном случае MarkLogic Server должен «знать» о всех используемых entity.

Читать полностью »

Аналитика в рознице: сегодня вы не купили презервативы, а магазин уже знает, когда вам пригодится скидка на детское питание

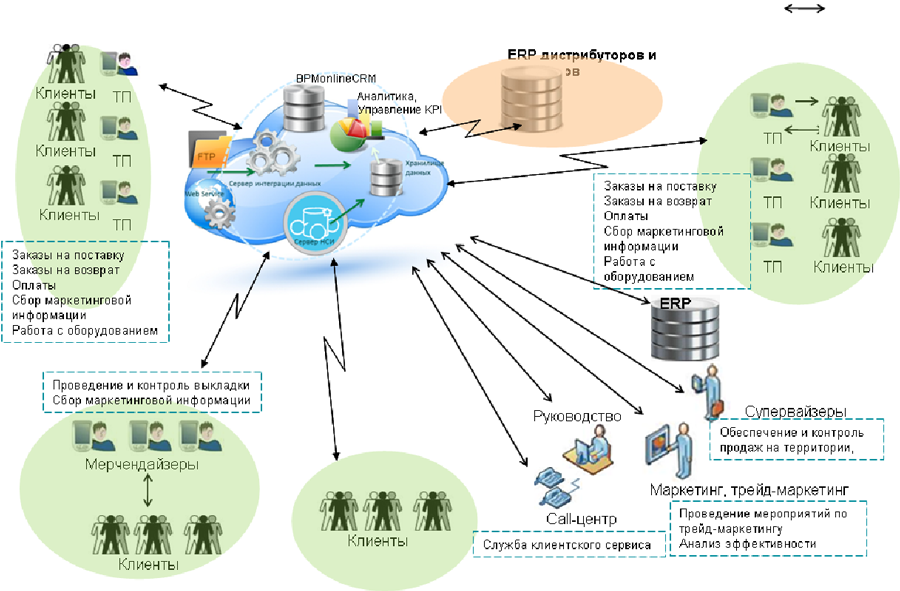

2013-09-19 в 12:44, admin, рубрики: big data, анализ данных, Блог компании КРОК, дистрибуция, Клиентская оптимизация, облако, отчетность, прогнозирование спроса, продажи, СУБД, управление проектами, метки: big data, анализ данных, дистрибуция, облако, отчетность, прогнозирование спроса, продажи, СУБД

Вот как-то так это хитро работает

Про вашего будущего ребёнка – это, конечно, утрировано, но все может быть. На практике мы помогаем рознице бороться за каждый рубль с помощью математического аппарата. Вот, например, у вас в бумажнике есть карта лояльности, либо вы расплачиваетесь кредиткой. Это значит, что в целом магазин знает, сколько и каких продуктов вам надо. Дальше можно построить оптимальную модель вашего путешествия по магазину и понять, в какой ситуации вы купите больше. Что где должно стоять, какое молоко вы предпочитаете (вдруг вы готовы брать дорогое и натуральное без колебаний?) и так далее. Смоделировать вас по совокупности данных легко.

Такую же аналитику можно применять ко всем аспектам работы розницы.

Из смешного — один раз система просчитала, что будет выгодно уничтожить примерно полтонны бумаги. Сначала думали, что баг — но начали копать и выяснили, что поставщик даёт скидку за определённый порог закупки. А сеть может не успевать продавать нужное количество бумаги. С учётом стоимости склада, поставки и уровня скидки начиная с порога — проще взять и уничтожить кучу товара, чтобы получать его по цене ниже. Скидка минимум вдвое компенсирует убытки от его потери. Читать полностью »

Big Data как инструмент выработки лояльности у клиентов платёжных систем

2013-09-06 в 10:05, admin, рубрики: big data, cpa network, Алгоритмы, базы данных, браузеры, монетизация проекта, платежные системы, программа лояльности, рамин алиев, стартап, управление проектами, метки: big data, cpa network, базы данных, монетизация проекта, платежные системы, программа лояльности, рамин алиев, стартап

Уже сегодня крупные компании начали движения в области сбора и анализа больших массивов данных, а некоторые начали их применять на практике. Рамин Алиев, CEO RBK Offers, приводит кейс работы с Big Data на примере проекта RBK Offers.

Читать полностью »

Hadoop Tutorial. Пишем свой grep

2013-08-12 в 9:13, admin, рубрики: Apache, big data, Hadoop, hello world, java, MapReduce, метки: big data, Hadoop, hello world, java, MapReduceДоброго времени суток, дорогое читатели. Не так давно я начал изучать работу с большими данными (Map/Reduce, NoSQL...) и очень быстро узнал о фреймворке с открытым исходным кодом Apache Hadoop, за изучение которого сразу и принялся.

Данный пост рассчитан на новичков, которые тоже не так давно начали изучать Hadoop. В посте будет разобрано небольшое приложение построенное на этом фреймворке(Этакий Hello World!). Кому интересно, добро пожаловать под кат.

Читать полностью »

Интеллектуальное извлечение данных. Основы web data extraction

2013-07-30 в 9:18, admin, рубрики: big data, data mining, метки: big data, data mining Мы (да и не только мы) уже рассказывали на хабре пару раз о проекте интеллектуального извлечения данных Convextra. Но предыдущие статьи это, по сути, обзоры сервиса, и его функциональности, а сегодня я хотел бы затронуть теоретическую и технологическую сторону вопроса извлечения данных. В русскоязычном сегменте очень немного информации, посвященной данной теме, и почти полностью отсутствует статьи о механизмах полуавтоматического или автоматического (интеллектуального) извлечения данных. Так как data extraction имеет непосредственное отношение к таким актуальным темам как data mining и Big Data, то, думаю, восполнение «информационного пробела» будет интересно довольно широкой аудитории. Намеренно постараюсь излагать на простом языке, поближе к этой самой «широкой аудитории». А извращенцев любителей матана ждут ссылки на источники внизу статьи, пройдя по которым, можно удовлетворить себя формулами, дифурами, матмоделями и строгим математическим описанием некоторых вопросов.

Правильное понимание геймификации

2013-07-25 в 11:49, admin, рубрики: big data, геймификация, Дизайн в IT, игрофикация, Инфографика, Социальные сети и сообщества, метки: big data, геймификация, игрофикация

Так получилось, что этот пост, я прочитал сравнительно недавно, а вот с геймификацией начал работать раньше. Единственное, что можно сказать по поводу прочитанного: «нечего на зеркало пенять».

Читать полностью »

ETegro Hyperion RS430 G4 – к Big Data готовы!

2013-07-18 в 12:34, admin, рубрики: big data, etegro, Блог компании «ETegro Tecnologies», сервер, метки: big data, etegro, серверПомимо вездесущих «облаков», одной из самых популярных и обсуждаемых тем в серверном мире сейчас является концепция работы с Большими Данными (Big Data) – очень большими объемами слабоструктурированных данных самого разнообразного вида. Мы не будем касаться вопросов программной обработки данных, а покажем ту платформу, на которой, по нашему мнению, это стоит делать: наш новый сервер ETegro Hyperion RS430 G4.

Простая методика построения фильтров товаров с помощью MongoDb и MapReduce

2013-07-14 в 11:06, admin, рубрики: big data, map reduce, mongodb, nosql, Веб-разработка, метки: big data, map reduce, mongodb, nosql, Веб-разработкаВпервые столкнувшись с MapReduce, я продолжительное время искал реальные примеры применения. Пресловутый поиск слов в тексте, встречающийся в каждой второй статье о MapReduce, искомым примером считать не будем. Наконец, на двух курсах по Big Data на Coursera, я нашёл не только живые примеры, но теоретическую подоплёку для более глубокого понимания происходящего. Возможность применить полученный багаж знаний не заставила себя долго ждать.

В этой небольшой статье я хочу поделиться опытом реализации классической для большинства Интернет-магазинов системы фильтров товаров по критериям применительно к туристическому порталу, где появилась задача поиска и фильтрации по базе в десятки тысяч отелей, каждый из которых описывается рядом параметров и наличием нескольких десятков предоставляемых сервисов из сотен возможных.

Читать полностью »

Map-Reduce на примере MongoDB

2013-06-21 в 10:43, admin, рубрики: big data, mongodb, nosql, метки: big data, map reduce, mongodb, nosqlВ последнее время набирает популярность семейство подходов и методологий обработки данных, объединенных общими названиями Big Data и NoSQL. Одной из моделей вычислений, применяемых к большим объемам данных, является технология Map-Reduce, разработанная в недрах компании Google. В этом посте я постараюсь рассказать о том, как эта модель реализована в нереляционной СУБД MongoDB.

Что касается будущего нереляционных баз вообще и технологии Map-Reduce в частности, то на эту тему можно спорить до бесконечности, и пост совершенно не об этом. В любом случае, знакомство с альтернативными традиционным СУБД способами обработки данных является полезным для общего развития любого программиста, так же как, к примеру, знакомство с функциональными языками программирования может оказаться полезным и для программистов, работающих исключительно с императивными языками.

Нереляционная СУБД MongoDB хранит данные в виде коллекций из документов в формате JSON и предоставляет разные способы обработки этих данных. В том числе, присутствует собственная реализация модели Map-Reduce. О том, насколько целесообразно применять именно эту реализацию в практических целях, будет сказано ниже, а пока ограничимся тем, что для ознакомления с самой парадигмой Map-Reduce эта реализация подходит как нельзя лучше.

Итак, что же такого особенного в Map-Reduce?

Читать полностью »