На эксклюзивных условиях представляем для вас полный вариант статьи из журнала Хакер, посвященной разработке на R. Под катом вы узнаете, как выжать максимум скорости при работе с табличными данными в языке R.

Рубрика «big data» - 84

Маленький код для больших данных или Apache Spark за 3 дня

2016-11-24 в 20:45, admin, рубрики: ASP, big data, java, spark, машинное обучениеПусть Жираф был не прав,

Но виновен не Жираф,

А тот, кто крикнул из ветвей:

«Жираф большой — ему видней!» (с)

Потребовалось оперативно разобраться с технологией Apache Spark заточенную для использования Big Data. В процессе выяснения активно использовал habrahabr, так что попробую вернуть информационный должок, поделившись приобретенным опытом.

А именно: установкой системы с нуля, настройкой и собственно программированием кода решающего задачу обработки данных для создания модели, вычисляющей вероятность банкротства клиента банка по набору таких признаков как сумма кредита, ставка и т.д.

Больших данных вроде как должно быть много, но почему-то не просто найти то злачное место, где их все щупают. Сначала попробовал вариант с ambari, но на моей Window7 валились ошибки настроек сетевого моста. В итоге прокатил вариант с преднастроенной виртуальной машиной от Cloudera (CDH). Просто устанавливаем VirtualBox, запускаем скачанный файл, указываем основные параметры (память, место) и через 5 минут достопочтенный джин Apache Hadoop жаждет ваших указаний.

Несколько слов, почему именно Spark. Насколько я понимаю, ключевые отличия от изначальной MapReduce в том, что данные удерживаются в памяти, вместо сброса на диск, что дает ускорение во много раз. Но, пожалуй, более важны реализации целого ряда статистических функций и удобным интерфейсом для загрузки/обработки данных.

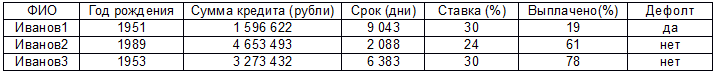

Дальше собственно код для решения следующей задачи. Есть реально большие данные (ибо рука очень устает скролить эти 2000 строк) в формате:

Есть предположение, что дефолт как-то связан с остальными параметрами (кроме первого, к уважаемым Ивановым1…N претензий нет) и нужно построить модель линейной регрессии. Прежде чем начать, стоит оговориться, что это мой первый код на Java, сам я работаю аналитиком и вообще это мой первый запуск Eclipse, настройка Maven и т.д. Так что не стоит ждать изысканных чудес, ниже решение задачи в лоб тем способом, который почему-то заработал. Поехали:

Читать полностью »

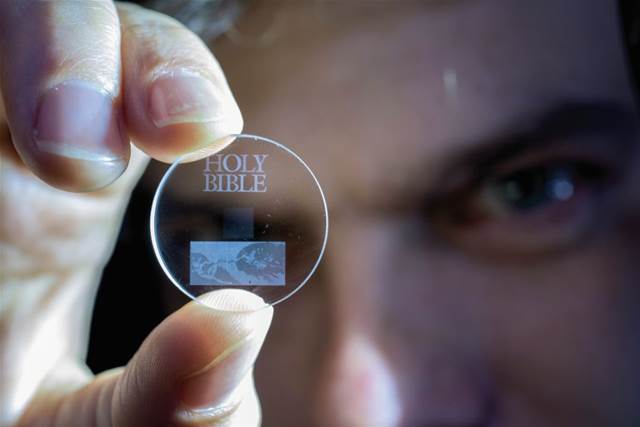

Информация на пороге бессмертия

2016-11-24 в 8:11, admin, рубрики: big data, Блог компании Cloud4Y, виртуализация, Облачные вычисления, хостинг, хранение данныхНа этой неделе на Хабре уже вышла статья о вечной флешке. Мы хотели бы продолжить обсуждение, предоставив сборный материал из нескольких зарубежных источников, рассказывающих о бессмертном флеш-накопителе. Как известно, некоторое время назад ученые создали накопители нового поколения — наноструктурированные стекла, срок действия которых может составлять миллиарды лет. DVD-диски могут хранить рабочую информацию или семейные фотографии от 20 до 200 лет, но исследователи из Университета Саутгемптона считают, что хранить информацию на одном накопителе можно и дольше — до 13,8 млрд. лет. Примерно столько могут хранить информацию наноструктуры 5D из плавленого кварца — по сути, до конца самого человечества.

Встреча любителей больших данных и искусства

2016-11-23 в 10:02, admin, рубрики: big data, DCA, Блог компании DCA (Data-Centric Alliance), искусство, машинное обучениеВо вторник, 29 ноября 2016 года DI Telegraph и Data-Centric Alliance проведут митап Art of Science.

Art of Science – мероприятие, посвященное анализу данных в искусстве. Наука и искусство – что их связывает? Возможно ли взаимодействие этих двух разных миров? Можно ли с помощью big data, нейронных сетей и методов машинного обучения создавать что-то полезное и прекрасное? Как наука о данных может помочь в решении задач современного искусства? Об этом и многом другом расскажут наши спикеры, представители мира технологического «искусства».

Читать полностью »

«Вечная флешка»: как создать надежный носитель, который сохранит данные на тысячи лет

2016-11-22 в 16:10, admin, рубрики: big data, IT-стандарты, Блог компании Фонд перспективных исследований, носители информации, хранение данных, метки: носители информацииСрок службы компакт-дисков, SSD- и HDD-дисков не превышает 10-20 лет. При этом мировой объем данных растет на 40% каждый год, что стимулирует спрос на накопители, однако долговечность носителей оставляет желать лучшего. Большая часть HDD перестают работать в течение нескольких лет: как правило, это связано с поломкой движущихся частей. Компакт-диски хранятся десятилетиями, но повышение температуры, влажности или механические повреждения делают доступ к информации затруднительным: поверхность диска отслаивается и легко царапается. SSD, рекламируемые сегодня как «неубиваемый» носитель, живут всего несколько лет, и обладают фиксированным количеством циклов перезаписи: циркулирующий внутри электрический заряд рано или поздно угасает даже в отсутствие активного доступа к содержимому. При этом ценность утраченной информации может быть очень высокой: например, это могут быть большие объемы технической документации или исторические архивы, восстановить которые будет невозможно.

www.ohmygeek.net

Еще примеры использования R для решения практических бизнес-задач

2016-11-22 в 14:24, admin, рубрики: big data, data mining, data science, RС момента прошлой публикации пришлось примеряться к ряду различных задач, связанных тем или иным образом с обработкой данных. Задачи совершенно разные, но во всех случаях инструменты R позволили элегантно и эффективно их решить. Ниже, собственно, кейсы (картинок нет). Читать полностью »

Конкурс проектов в сфере рекламных технологий Go to AdTech

2016-11-20 в 11:35, admin, рубрики: big data, brand safety, geofencing, go to adtech, gotech, viewability, Блог компании GoTech.vc, конференции, Монетизация IT-систем, Монетизация веб-сервисов, Монетизация мобильных приложений, нативная реклама, новые медиа, реклама, реклама в ITФонд the Untitled ventures объявил конкурсный отбор проектов в сфере рекламных технологий и новых медиа – Go to AdTech. Победитель получит инвестиционное предложение на $ 100 000. Оператор конкурса – фонд GoTech.

Заявки на участие принимаются до 6 декабря. 12 отобранных проектов будут приглашены на финал в формате road show 16 декабря, где выступят перед руководителями ведущих рекламных агентств и медиа-площадок, а также профильными инвесторами. Все финалисты получат прямой контакт с потенциальными заказчиками, экспертную и PR-поддержку на рекламном рынке. Победитель конкурса получит инвестиционное предложение на $ 100 000 от фонда the Untitled ventures.Читать полностью »

Программа по Deep Learning

2016-11-18 в 12:58, admin, рубрики: artifical intelligence, big data, data mining, deep learning, Блог компании New Professions Lab, глубокое обучение, искусственный интеллект, машинное обучение Из уважения к тем из вас, кто на дух не переносит здесь рекламу, сразу сообщим — да, это рекламный пост. Можно проскроллить дальше. Тем, кто считает, что реклама не всегда вредна и порой помогает принимать нам важные решения, добро пожаловать под кат.

Читать полностью »

Искусственный интеллект, вызовы и риски – глазами инженера

2016-11-17 в 10:26, admin, рубрики: big data, BigData, Алгоритмы, Блог компании 1С-Битрикс, машинное обучение, нейронные сети, разработкаДобрый день, коллеги. Сегодня хочется трезво посмотреть глазами инженера на так популярные сейчас искусственный интеллект и Deep learning, упорядочить, выстроить факты и выработать выигрышную стратегию – как с этим … взлететь, пролететь и не упасть кому-нибудь на голову? Потому-что, когда дело от лабораторных моделей на python/matplotlib/numpy или lua доходит до высоконагруженного production в клиентском сервисе, когда ошибка в исходных данных сводит на нет все усилия – становится не то, что весело, а даже начинается нумерологический средневековый экстаз и инженеры начинают сутки напролет танцевать, в надежде излечиться от новомодной чумы )

Танцующие инженеры, тщетно надеющиеся исцелиться

Читать полностью »

Mail.ru Group вышел на рынок оценки эффективности офлайн-рекламы вслед за «Яндексом»

2016-11-15 в 11:27, admin, рубрики: big data, mail.ru group, аналитика, кейсы, яндекс, метки: big data, mail.ru group, аналитика, кейсы, яндексХолдинг Mail.Ru Group совместно с «НПО Аналитика» (российский разработчик системы анализа потребительского поведения на основе данных от устройств, подключенных к Wi-Fi) создали систему анализа Big Data для оценки эффективности рекламы офлайн-магазинов, говорится в сообщении холдинга. Система позволит рекламодателям лучше узнать свою офлайн-аудиторию и изучить ее реакцию на рекламные кампании.

В частности, Читать полностью »