Начинать чинить надо, пока не сломалось — сломанное поддаётся ремонту гораздо неохотней.

Юрий Татаркин

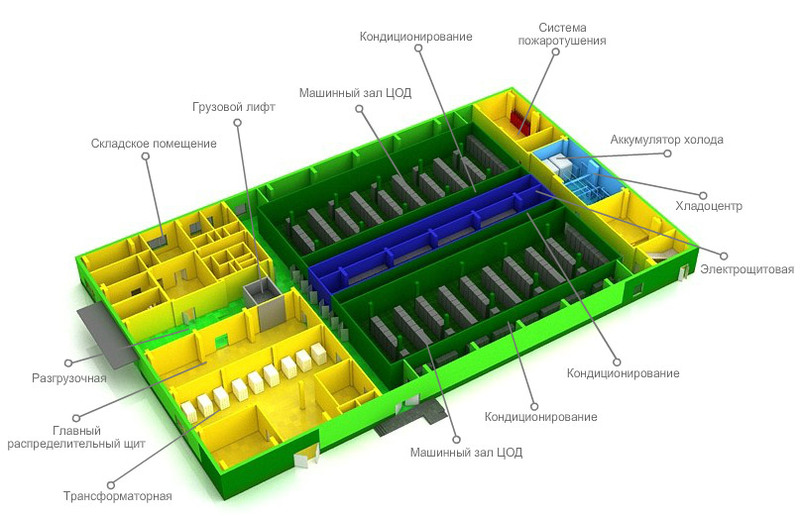

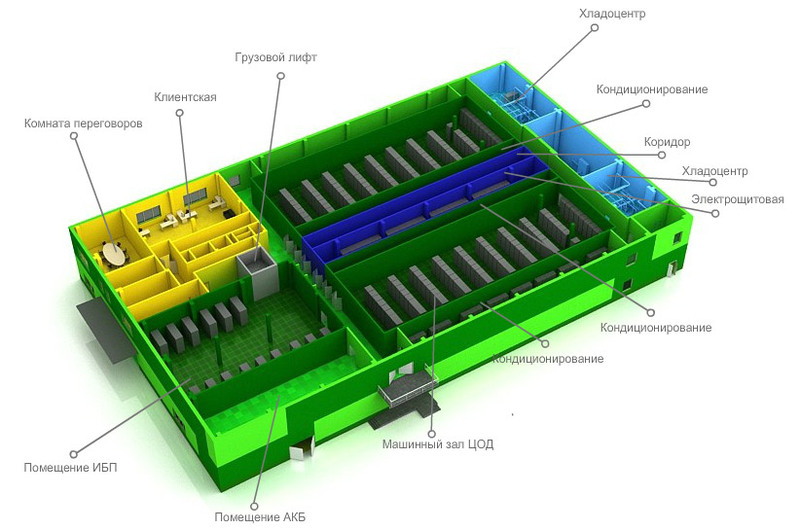

После того как обеспечены надежные стены и крыша над головой для ЦОД (статья «Риски ЦОД: выбираем месторасположение»), следующим шагом на пути обеспечения его отказоустойчивости должно стать резервирование инженерных систем. Строя дата-центры более 10 лет, мы убедились, что не все заказчики в полной мере осознают важность дублирования основных коммуникаций. Космические корабли и те падают, а оборудование в ЦОД в идеале должно работать 365 дней в году и 24 часа в сутки. Любая вышедшая из строя или нуждающаяся в профилактике деталь должна быть заменена без остановки работы всех критичных сервисов.

После того как обеспечены надежные стены и крыша над головой для ЦОД (статья «Риски ЦОД: выбираем месторасположение»), следующим шагом на пути обеспечения его отказоустойчивости должно стать резервирование инженерных систем. Строя дата-центры более 10 лет, мы убедились, что не все заказчики в полной мере осознают важность дублирования основных коммуникаций. Космические корабли и те падают, а оборудование в ЦОД в идеале должно работать 365 дней в году и 24 часа в сутки. Любая вышедшая из строя или нуждающаяся в профилактике деталь должна быть заменена без остановки работы всех критичных сервисов.

Как справедливо отметили наши читатели, далеко не всем компаниям нужен надежный ЦОД. Для некоторых его бесперебойная работа не предмет переживаний, а многие предпочтут хранить свои данные в публичном облаке. Данный паблик предназначен в большей степени для тех, кто по тем или иным соображениям безопасности или проходимости каналов связи сделал свой выбор в пользу собственного дата-центра и работы сервисов с уровнем доступности не менее трех девяток (простоя не более 1,6 часов в год).