Федеральное агентство по техническому регулированию и метрологии (Росстандарт) создаст комитет для разработки стандартов в сфере «больших данных», «интернета вещей» и «умных городов», пишет газета «Известия» со ссылкой на приказ ведомства. Среди организаций, чьи представители войдут в комитет — «Ростелеком», «Газпром нефть», «Ангстрем-Т», а также некоммерческие партнерства Читать полностью »

Рубрика «big data» - 76

Росстандарт пропишет национальный стандарт для «больших данных» и IoT

2017-04-18 в 9:13, admin, рубрики: big data, ангстрем, рвк, Ростелеком, Руссофт, Текучка, метки: big data, Ангстрем, рвк, Ростелеком, Руссофт, ТекучкаData science и качественный код

2017-04-17 в 9:53, admin, рубрики: big data, data mining, data science, machine learning, python, машинное обучениеОбычно модели машинного обучения строят в jupyter-ноутбуках, код которых выглядит, мягко говоря, не очень — длинные простыни из лапши выражений и вызовов "на коленке" написанных функций. Понятно, что такой код почти невозможно поддерживать, поэтому каждый проект переписывается чуть ли не с нуля. А о внедрении этого кода в production даже подумать страшно.

Поэтому сегодня представляем на ваш строгий суд превью библиотеки по работе с датасетами и data science моделями. С ее помощью ваш код может выглядеть так:

my_dataset.

load('/some/path').

normalize().

resize(shape=(256, 256, 256)).

random_rotate(angle=(-30, 30))

random_crop(shape=(64, 64, 64))

for i in range(MAX_ITER):

batch = my_dataset.next_batch(BATCH_SIZE, shuffle=True)

# обучаем модель, подавая ей батчи с данными В этой статье вы узнаете об основных классах и методах, которые помогут сделать ваш код простым, понятным и удобным.

Быстрая загрузка данных из файлов в R

2017-04-16 в 13:05, admin, рубрики: big data, data mining, R, высокая производительность, производительностьНедавно мы писали приложение на Shiny, где нужно было использовать очень большой блок данных (dataframe). Это непосредственно влияло на время запуска приложения, поэтому пришлось рассмотреть ряд способов чтения данных из файлов в R (в нашем случае это были csv-файлы, предоставленные заказчиком) и определить лучший.

Цель этой заметки — сравнить:

read.csvизutils— стандартный способ чтения csv-файлов в Rread_csvизreadr, который в RStudio заменил предыдущий методloadиreadRDSизbase, иread_featherизfeatherиfreadизdata.table.

Разница между российскими и американскими законами по Big Data — штраф на $500

2017-04-14 в 11:45, admin, рубрики: big data, Закон о персональных данных россиян, кейсы, мгтс, Роскомнадзор, суд, метки: big data, Закон о персональных данных россиян, кейсы, мгтс, Роскомнадзор, судРуководитель Центра компетенций по импортозамещению в сфере информационно-коммуникационных технологий Илья Массух обратил в своем Facebook внимание на решение Арбитражного суда Москвы по делу против МГТС. Провайдер заключил с рядом компаний договор по продаже им истории посещений сайтов браузеров пользователей. В частности такие соглашения были заключены с дочкой крупнейшего сейлс-хауса «Видео Интернешнл» ООО «Читать полностью »

RStudio Connect — «фейслифтинг» Shiny для корпоративного применения

2017-04-11 в 14:30, admin, рубрики: big data, data mining, data science, RПрошло достаточно времени с упоминания в предыдущей публикации об использовании RStudio Connect в боевых условиях для того, чтобы поделиться результатами. Краткое резюме — «дайте два!». И подумайте про оптимизацию отдела «аналитиков». Ниже приведены подробности.

В качестве дополнительного чтения рекомендую взглянуть детальную публикацию «Data at GDS (Government Digital Service). Reproducible Analytical Pipeline» в блоге аналитической службы гос.органов UK по аналогичной теме.

Курсы Computer Science клуба, весна 2017

2017-04-10 в 12:21, admin, рубрики: big data, CUDA, functional programming, gpgpu, gpu, gpu programming, idris, spark, Блог компании СПБАУ, Большие данные, зависимые типы, функциональное программирование

Computer Science клуб вот уже 10 лет проводит открытые курсы по компьютерным наукам. Большинство этих лекций стараниями Лекториума записаны на видео и лежат в открытом доступе. В этом семестре выложены уже три новых курса, которые до этого не читались в клубе: «Программирование с зависимыми типами на языке Idris», «Вычисления на GPU. Основные подходы, архитектура, оптимизации», «Методы и системы обработки больших данных».

Читать полностью »

Быстрый старт: обзор основных Deep Learning фреймворков

2017-04-06 в 11:02, admin, рубрики: big data, caffe, data mining, deep learning, keras, microsoft CNTK, paddle, TensorFlow, theano, torch, Блог компании New Professions Lab, машинное обучениеПривет! Предлагаем вам перевод поста “Getting Started with Deep Learning” от Мэтью Рубашкина из Silicon Valley Data Science о преимуществах и недостатках существующих Deep Learning технологий и о том, какой фреймворк выбрать, учитывая специфику задачи и способности команды.

Кинетика больших кластеров

2017-04-06 в 9:40, admin, рубрики: big data, Алгоритмы, Анализ и проектирование систем, высокая производительность, кинетика, Промышленное программирование, распределенные системы, репликация, метки: кинетикаКраткое содержание

- Фатальная ошибка Мартина Клеппмана.

- Физико-химическая кинетика уделывает математику.

- Период полураспада кластера.

- Решаем нелинейные дифференциальные уравнения, не решая их.

- Ноды как катализатор.

- Предсказательная сила графиков.

- 100 миллионов лет.

- Синергия.

В предыдущей заметке мы подробно разбирали статью Брюера и его одноименную теорему. На этот раз займемся препарированием поста Мартина Клеппмана «The probability of data loss in large clusters».

В данном посте автор пытается промоделировать следующую задачу. Для обеспечения сохранности данных обычно используется метод репликации данных. При этом, на самом деле, не важно, используется ли erasure кодирование или нет. В оригинальном посте автор задает вероятность выпадения одной ноды, а затем ставит вопрос: а какова вероятность выпадения данных при увеличении числа нод?

Ответ приведен на этой картинке:

Читать полностью »

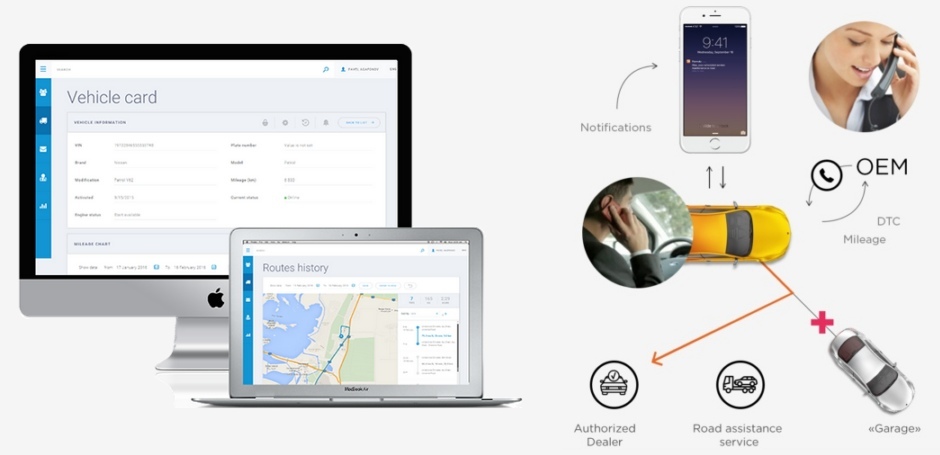

Big Data для автодилера и автопроизводителя: от идеи до монетизации

2017-04-05 в 10:18, admin, рубрики: big data, BigData, remoto, автопром, анализ данных, Аналитика мобильных приложений, Блог компании Bright Box, Монетизация IT-системIHS Automotive предсказывает, что к 2020 порядка 152 миллионов «подключенных» машин будут ежедневно генерировать до 30 терабайт данных. И бизнес, который сумеет грамотно воспользоваться этим богатством, очевидно, окажется «на коне». Поговорим о том, какую информацию можно использовать и что для этого нужно.

Школа данных: Москва, Питер… онлайн

2017-04-03 в 22:10, admin, рубрики: big data, data mining, kaggle, R, sna, Алгоритмы, алгоритмы обработки данных, анализ данных, анализ социальных сетей, машинное обучение, рекомендательные системы, школа данных

Привет,

Можно ли с помощью данных управлять миром? Ну, ответ, очевиден. Вопрос в том, как…

Все уже слышали об успехе компании CambridgeAnalytica в предвыборной гонке Трампа и небезызвестного Brexit.

Статья собрала большое количество поклонников. В ней рассказаны потрясающие результаты, которых позволяет добиться современная аналитика. Однако, эти результаты достижимы только при соблюдении определенных нюансов, о которых умолчали авторы статьи и о которых мы хотели бы рассказать. Эти нюансы могут превратить данную задачу из легко решаемой в невозможную или наоборот.

Читать полностью »