Во время общения с медиа мы в Relap.io часто сталкиваемся с массой заблуждений, в которые все верят, потому что так сложилось исторически. На сайте есть блоки типа «Читать также» или «Самое горячее» и т.п. Словом, всё то, что составляет обвязку статьи и стремится дополнить UX дорогого читателя. Мы расскажем, какие заблуждения есть у СМИ, которые делают контентные рекомендации, и развеем их цифрами.

Рекомендовать по тегам

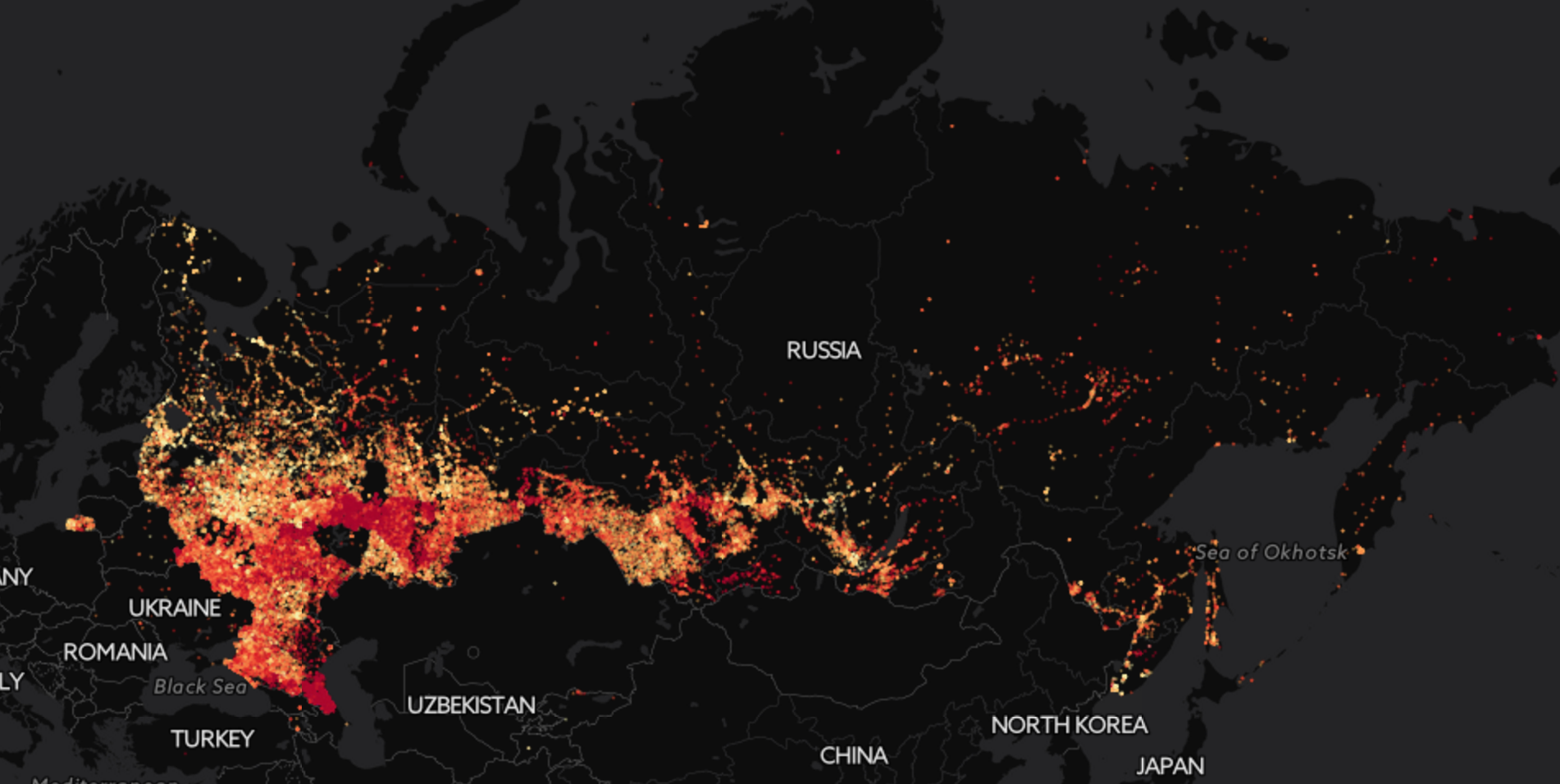

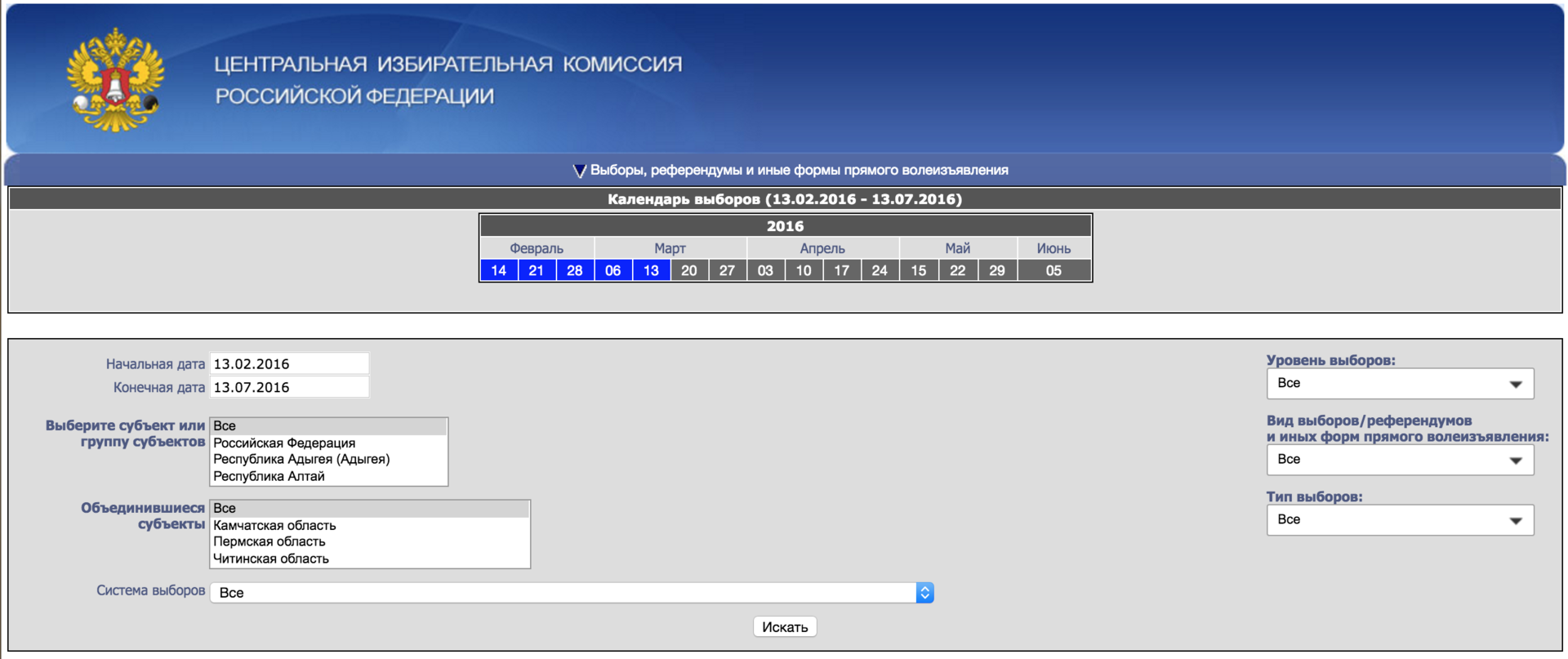

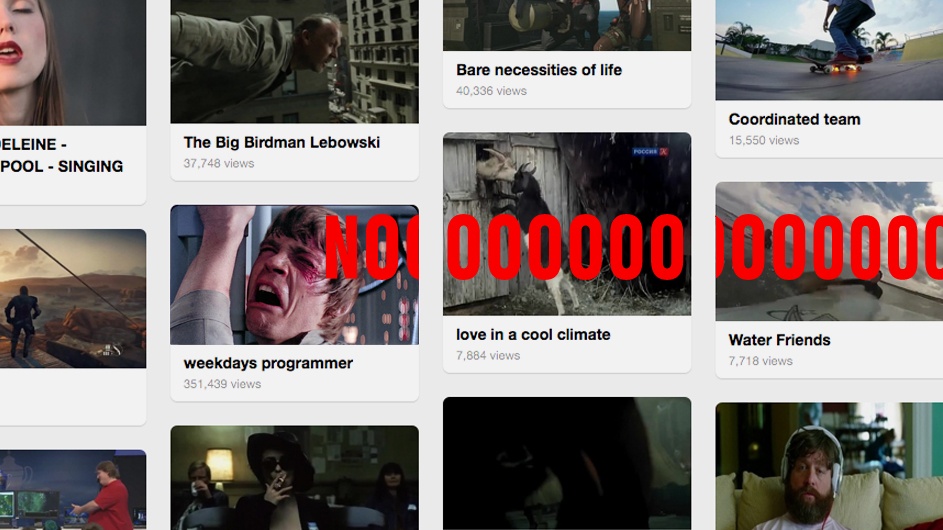

Самое большое и самое популярное заблуждение. Чаще всего СМИ делают рекомендации в конце статьи по тегам. Так поступает Look At Me и РБК, например. Есть материал с тегами: трактор, Путин, сыр. К нему выводятся тексты про трактора, про Путина и сыр. На первый взгляд, логично:

Подобная механика рекомендаций в реальной жизни выглядела бы так. Вы идёте в магазин за продуктами. И кладёте в корзину сливочное масло. К вам подходит консультант с потными от волнения ладошками и говорит: «О, я вижу, вы взяли масло и это значит, что вам нужно масло. Возьмите еще пять видов сливочного деревенского и подсолнечного и козьего масла». Максимум, что может случиться из ряда вон выходящее — вам предложат трансмиссионное, если вы читали что-то про автомобили. И это уже будет считаться rocket science.Читать полностью »