Часть I: Основы

«В теории теория и практика одинаковы. На практике это не так». — авторство приписывается разными специалистам по computer science

«В теории теория и практика одинаковы. На практике это не так». — авторство приписывается разными специалистам по computer science

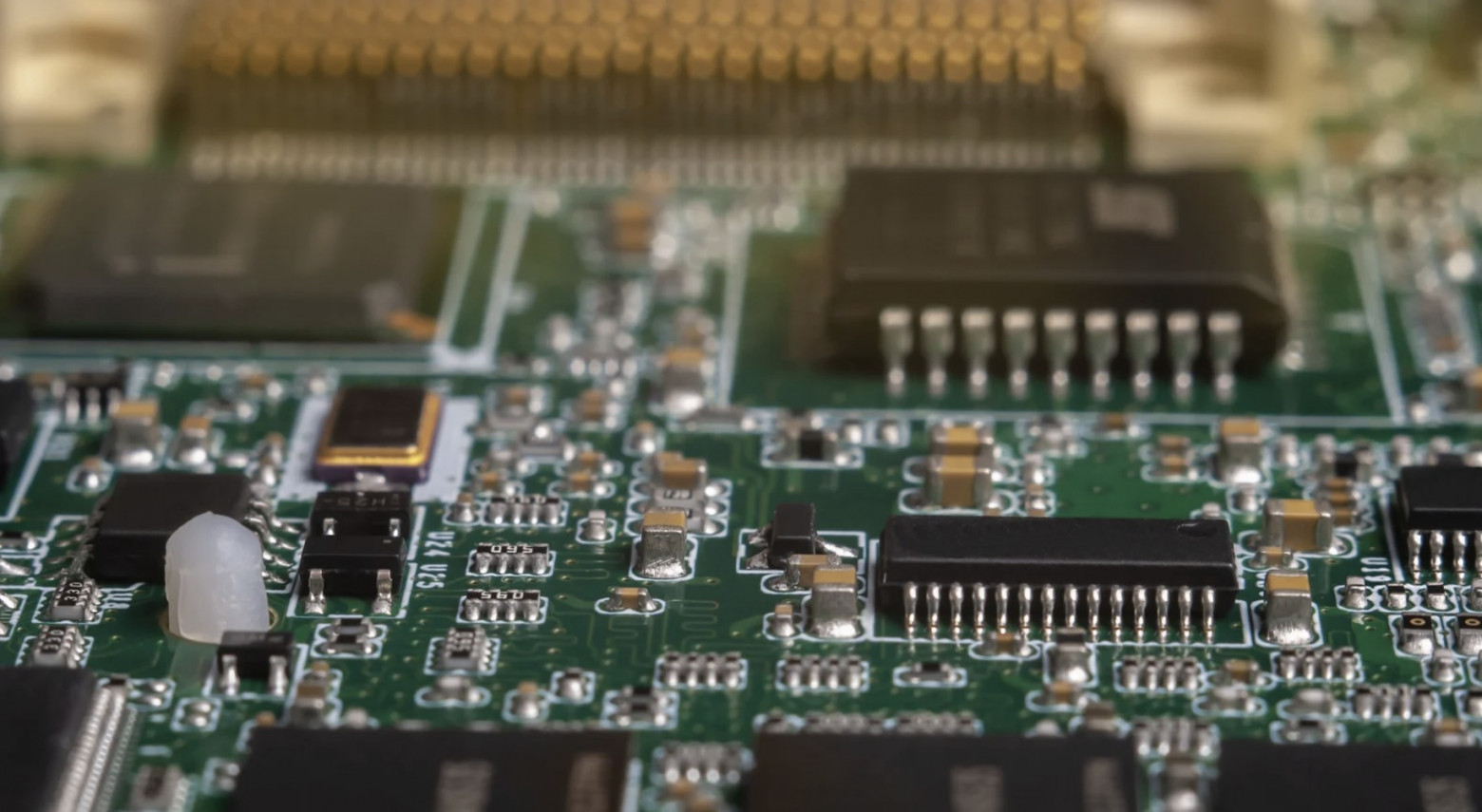

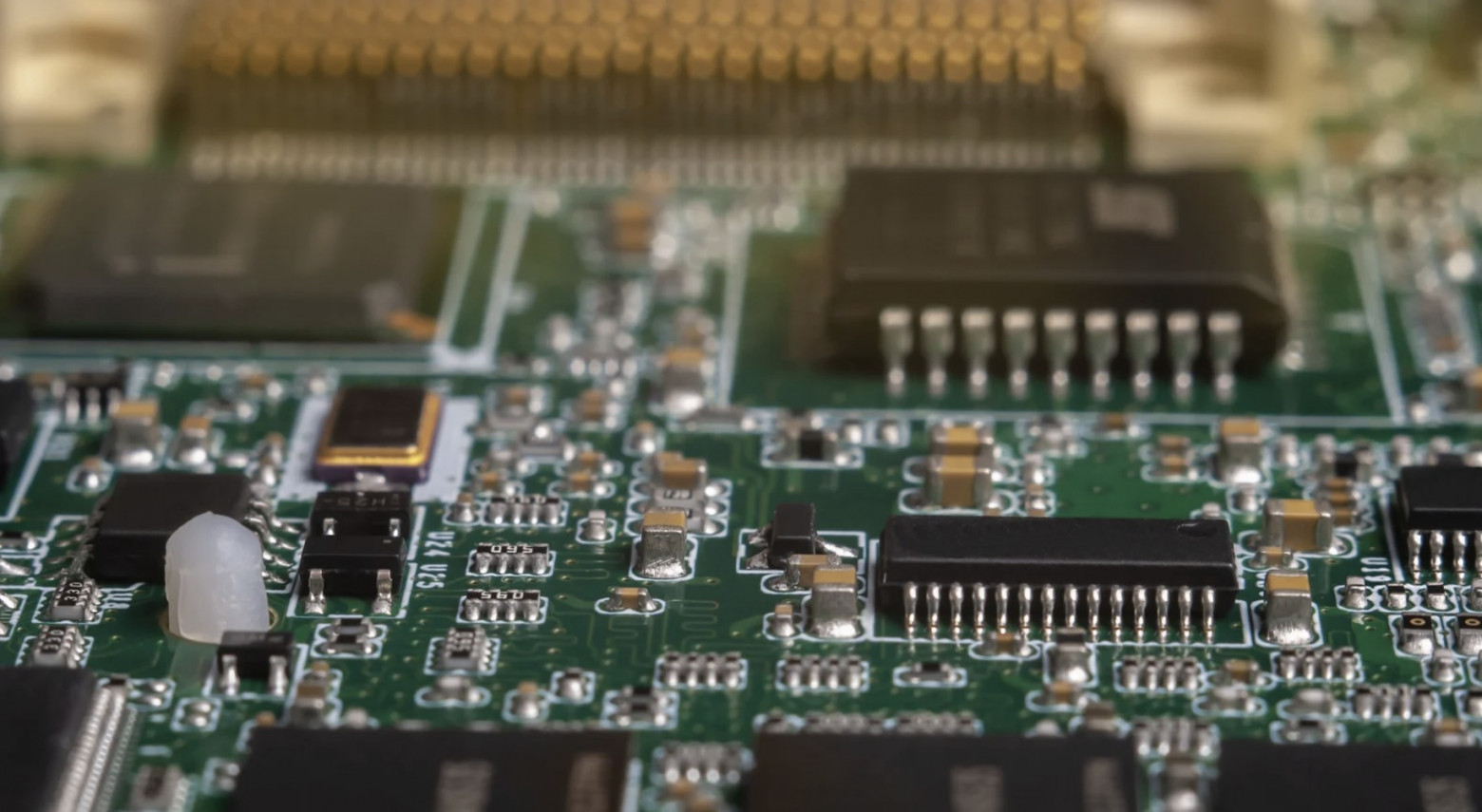

Месяц назад мне в телеграм написал человек и предложил доступ к системе с процессором Эльбрус-8СВ.

И конечно же я согласился. Так как мне интересно.

Не каждый день неизвестные люди предлагают доступ к удалённым хостам.

Меня зовут Леонид Лагунов и я математик-программист.

Я решил написать про своё знакомство с процессором Эльбрус.

В одном из моих докладов по ассемблеру я показал список из 20 самых часто исполняемых команд на среднем десктопе x86 с Linux. Разумеется, в этом списке были привычные mov, add, lea, sub, jmp, call и так далее; неожиданным стало включение в него xorЧитать полностью »

Здравствуйте, друзья, меня зовут Ерохин Кирилл, я программист‑любитель, и в этом сентябре я втихаря провёл соревнование по алгоритмическому программированию на C/C++ под платформу «Эльбрус» (e2k), собрав 31 участника со всей России, результатами которого я решил поделиться с вами. А Хабр мне в этом поможет, ему не впервой.

Оглавление:

Антонио Куни — инженер, давно занимающийся повышением производительности Python, а также разработчик PyPy. Он провёл на EuroPython 2025Читать полностью »

Пришел к хитрому паттерну. Делюсь.

Будет полезен тем кому нравиться или приходится работать с Vue.

В подходящей ситуации он сэкономит кучу времени и поможет избежать дублирования кода.

Есть несколько компонентов.

Компоненты должны выполнять одинаковую сложную логику.

Компоненты должны принимать одинаковые свойства и эмитить одинаковые события.

Свойства из composable могут быть опциональными со значениями по умолчанию.

Каждый компонент выглядит совершенно по разному (разная вёрстка).

Каждый компонент, опционально, в дополнение к общему, может:

Всем привет! Меня зовут Владимир Пустовалов, я C++ разработчик в команде Deckhouse компании «Флант». Мои коллеги — DevOps-инженеры — на данный момент обслуживают более 600 кластеров, и, естественно, в каждом из них развёрнута система мониторинга.

Изначально мы использовали Prometheus — опенсорсную систему мониторинга, написанную на Go. По нашей статистике, она занимала около 20 % ресурсов каждого кластера. Мы не могли с этим мириться и поэтому разработали проект под названием Prom++, в котором многократно сократили потребление оперативной памяти и снизили нагрузку на центральный процессор.

Эта статья — краткая заметка о двух связанных друг с другом эмпирических правилах.

Если внутри функции есть условие if, то подумайте, нельзя ли его переместить в вызывающую сторону:

Читать полностью »