Специалист без доступа к ChatGPT сегодня сродни бухгалтеру XX века без компьютера. Конечно, он может работать, но не так эффективно.

Ещё немного, и владение ChatGPT станет почти обязательным требованием квалифицированного сотрудника по многим специальностям. Поэтому печально, что разработчики OpenAI ограничили тестирование инструмента только пользователями с зарубежными SIM-картами. В этой ситуации у нас три выхода:

- Съездить в соседнюю страну и приобрести SIM-карту (например, в Польше она стоит 5 злотых у оператора Play24, без абонентской платы, и многократно пригодится в будущем, так что это полезная инвестиция).

- Купить «одноразовую» виртуальную симку на одном из полулегальных сервисов, чтобы получить SMS (без гарантии, потому что эту симку тысячи раз перепродают).

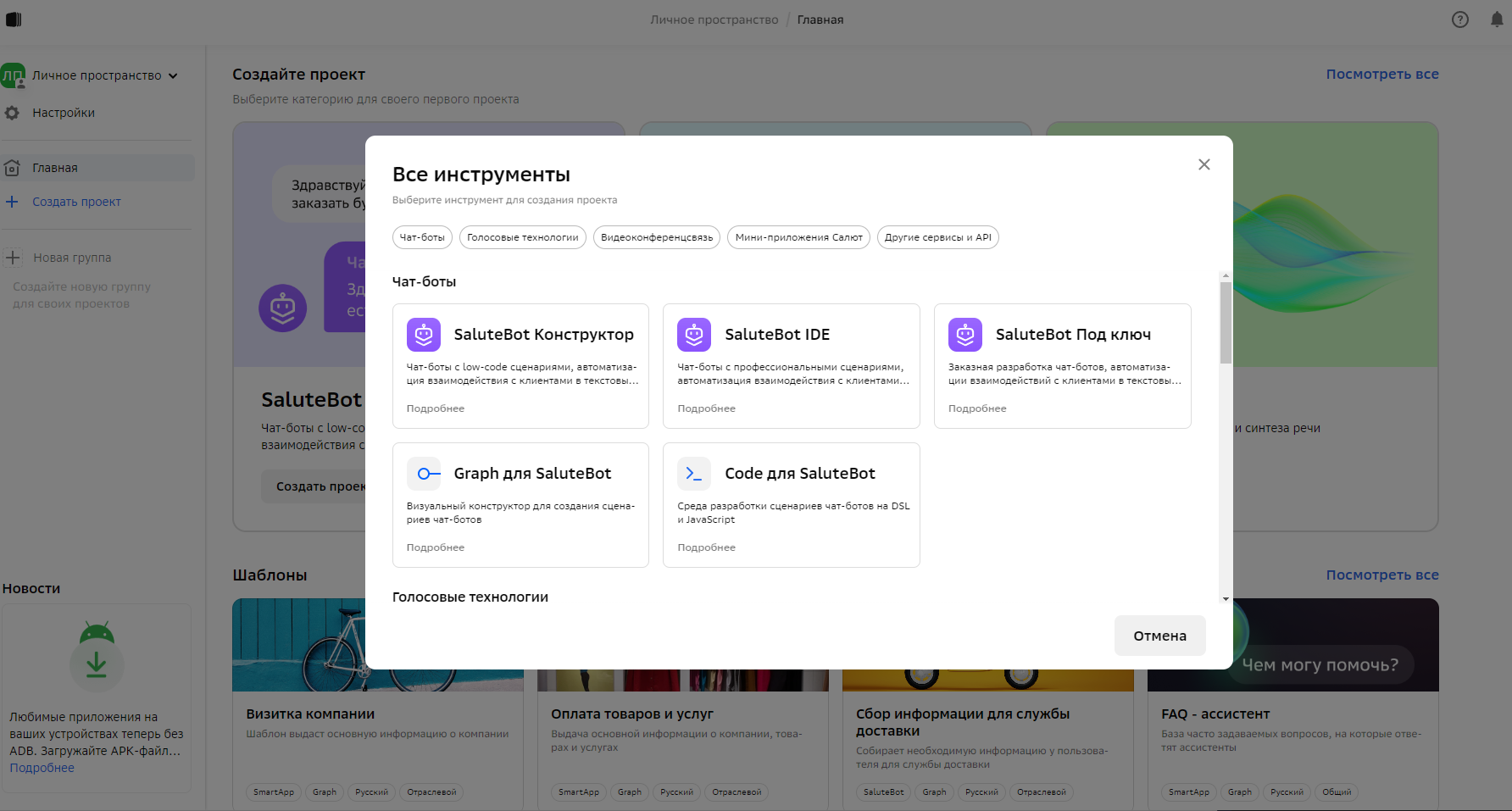

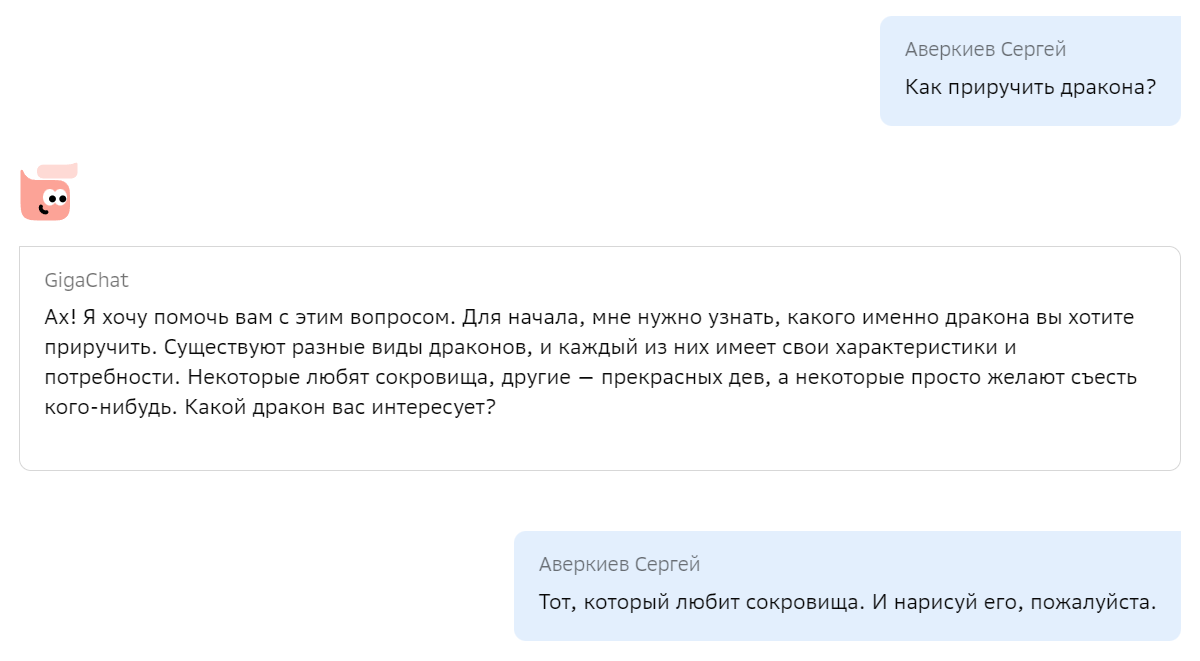

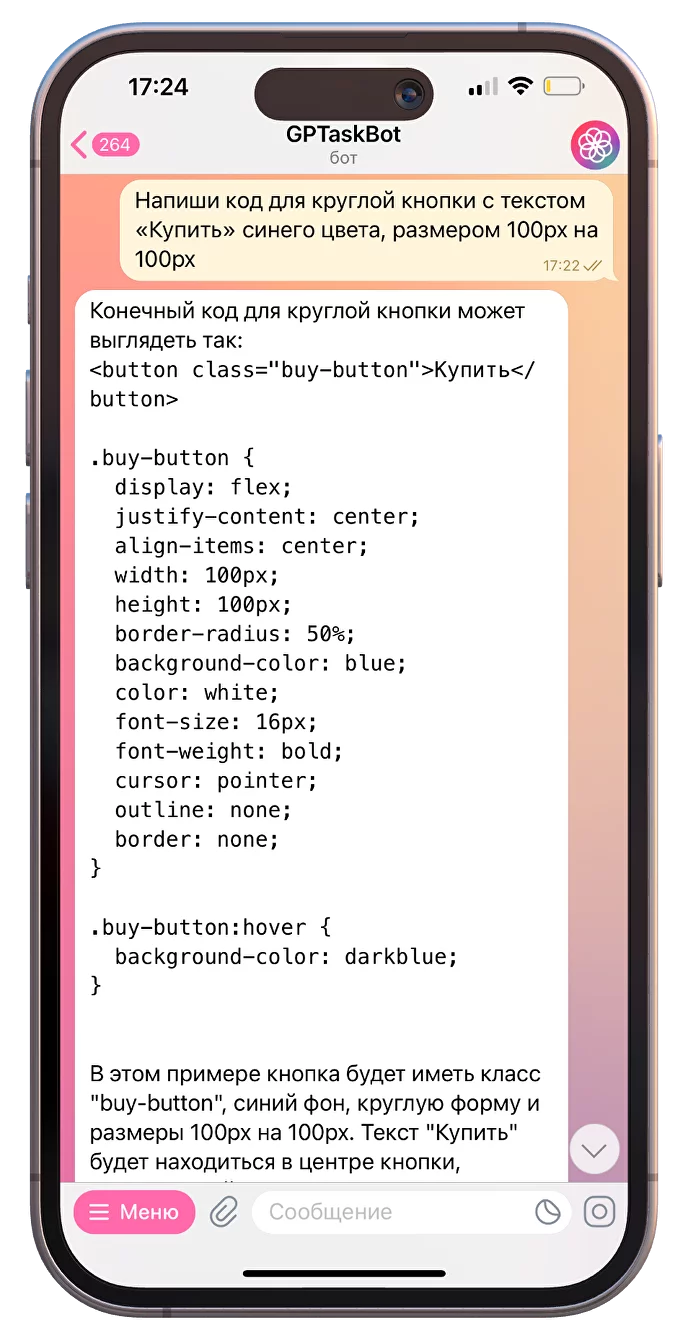

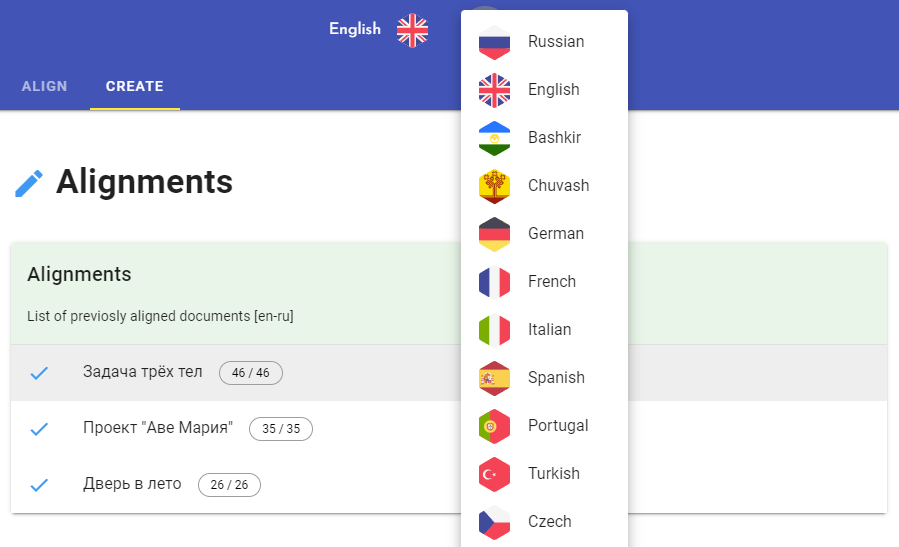

- Воспользоваться сторонним фронтендом, который даёт доступ к ChatGPT из России без VPN и СМС.

На третьем пункте и остановимся. Любопытно, что созданием таких фронтендов занялись в основном русскоязычные разработчики, потому что на западе у всех есть доступ к оригиналу, а вот в РФ это проблема. Статья о регистрации ChatGPT на левую симку стала самой популярной на Хабре за последние несколько лет, если не подводит память (1,2 млн просмотров).

Читать полностью »