Рубрика «SSL»

Дом в облаке, которое твое: запускаем личный сервер на UmbrelOS с полным шифрованием

2025-10-06 в 6:19, admin, рубрики: diy-проекты, HTTPS, nextcloud, nginxproxymanager, reverse-proxy, SSL, ssl сертификаты, UmbrelOSПолучаем Fullchain-сертификат с помощью PowerShell

2025-08-17 в 15:49, admin, рубрики: powershell, SSL, windows, системное администрированиеБерём анализы на болезни TLS у Гемотеста

2025-07-25 в 19:36, admin, рубрики: email, smtp, SSL, TLS, гемотест, медицина, персональные данные, почтовый сервер, сертификаты, шифрование17 июля я сдал анализы крови в компании Гемотест. Спустя полтора дня мне пришёл email с результатами на адрес, который я указал перед сдачей. К счастью, с анализами было всё хорошо: у меня нет ВИЧ, гепатита B, гепатита C, сифилиса, ура! PDF с анализами было заверено приложенной электронной подписью с инструкцией по проверке. Было внутри даже такое:

Тайное уравнение, позволявшее США следить за всеми

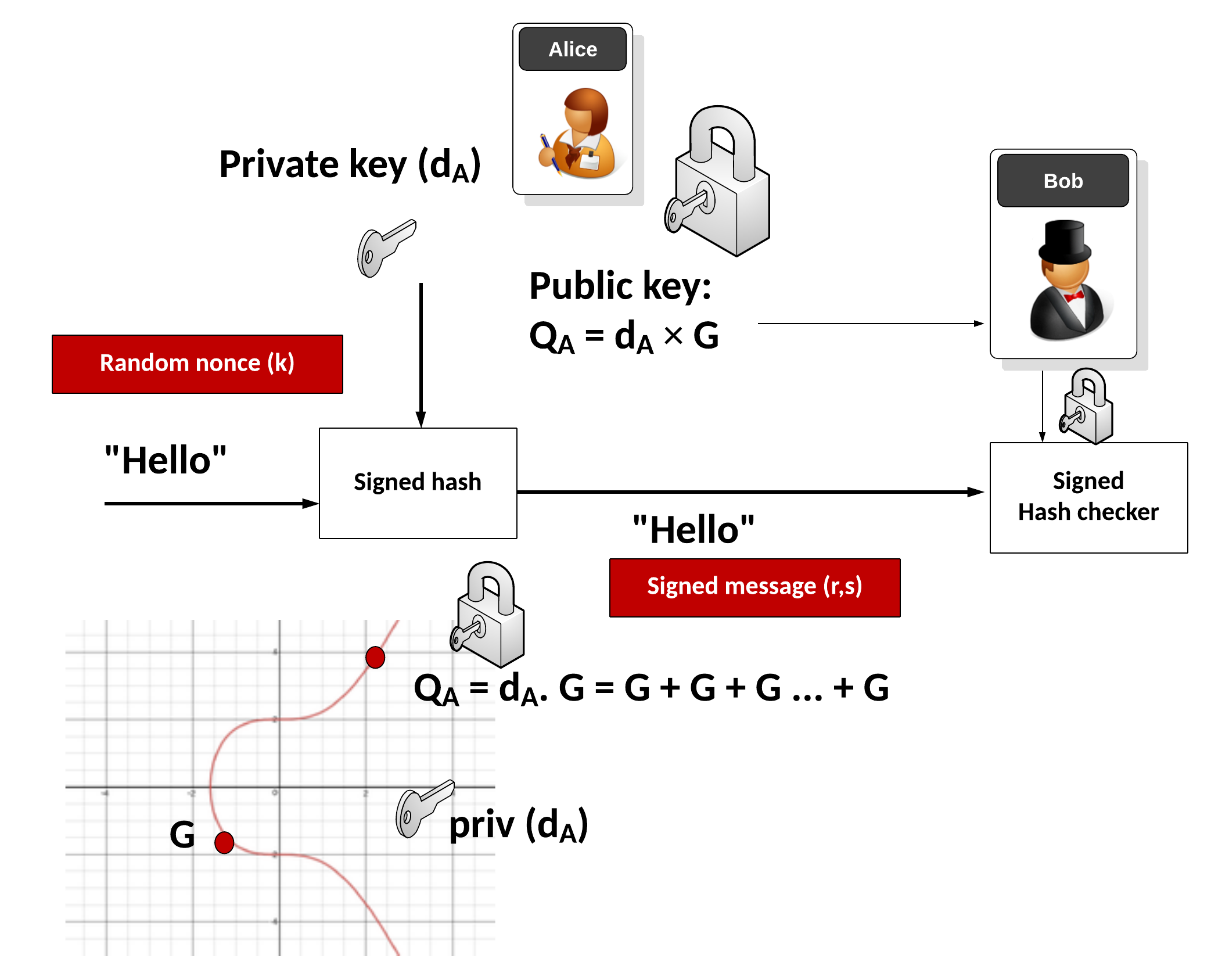

2025-06-20 в 9:02, admin, рубрики: mitm, NIST, SSL, шифрование, эллиптические кривые1.0 Введение

В 2006 году АНБ скрыла в криптографическом стандарте Dual EC DRBG математический бэкдор. Агентство отрицало его наличие восемь лет. Затем утечки Сноудена подтвердили его существование.

Двойные эллиптические кривые (Dual Elliptic Curve) используются как безопасные генераторы случайных чисел (RNG). Математический бэкдор позволял правительству США расшифровывать SSL-трафик Интернета (Green 2013)1.

Эта статья будет технически глубоким исследованием для программистов. Мы реализуем и исходную правительственную научную статью (SP 800-90 2006)2Читать полностью »

Как настроить автоматическое обновление SSL-сертификатов Let’s Encrypt с помощью Certbot на Ubuntu

2025-05-13 в 19:15, admin, рубрики: certbot, devops, HTTPS, LetsEncrypt, SSL, Ubuntu, автоматизация, безопасность, настройка сервера, системное администрированиеДопустим, вы не девопс. Вы — вполне себе фронтендер, бэкендер, может даже мобильщик. Но вот беда: у вас сервер, и ему нужен SSL. А девопс уехал в отпуск. Или вообще не нанят. И вот вы стоите, глядите на терминал и думаете: «Ну всё, теперь я — DevOps». 😅

Пугаться не стоит. Сегодня расскажу, как быстро и автоматически настроить SSL-сертификаты от Let’s Encrypt с помощью Certbot на Ubuntu. С шутками, примерами и bash-магией.

🔒 Зачем нужен Certbot и Let’s Encrypt?

Let’s Encrypt — это бесплатный центр сертификации. Он позволяет выпускать SSL-сертификаты для HTTPS. Certbot — это утилита для автоматического получения и обновления этих сертификатов.

DevOps инфраструктура для стартапов ч.1

2025-04-24 в 22:46, admin, рубрики: devops, docker, docker swarm, kubernetes, Portainer, SSL, traefik, инфраструктура, стартапЭто первая часть из цикла статей посвященных инфраструктуре для стартапов. Всего их будет три, поделенные, по-моему мнению, на логически законченные блоки.

Часть первая. Настройка окружения

Часть вторая. CI/CD и советы

Для кого эта статья

Эта статья будет полезна, если вы:

-

Запускаете стартап или пет-проект и хотите минимальными усилиями и затратами настроить инфраструктуру

-

Уже немного разбираетесь в Docker и хотите что-то посерьёзнее, но без оверинженеринга

-

Ищете альтернативу Kubernetes, которую можно легко развернуть и поддерживать без отдельного DevOps-инженера

Что делать, когда истёк TLS-сертификат на ТВ-приставку

2025-04-20 в 17:37, admin, рубрики: CastV2, Chromecast, chromium, hdmi, SSL, TLS, донглы, запланированное устаревание, окирпичивание, управление PKI

Chromecast второго поколения

9 марта 2025 года владельцы медиаприставок Chromecast второго поколения и Chromecast Audio столкнулись с неожиданной проблемой — все устройства прекратили работать. Как потом выяснилась, проблема была в просроченном TLS-сертификате.

Это новая причина, по которой оборудование может выйти из строя в 21 веке.

Читать полностью »

Передача пароля по интернету: что безопаснее — хэширование или TLS?

2025-03-31 в 8:15, admin, рубрики: SSL, TLS, tls 1.2, пароли, пароль, парольная защита, хэш, хэширование, хэширование паролейО данной статье я задумался ещё год назад, когда преподаватели из моего института начали приставать ко мне с вопросами о "безопасной" передаче пароля, но руки дошли только сейчас.

Суть дилеммы состоит в непонимании работы сертификации серверов и защищённых сетей как со стороны преподавателей, так и с моей стороны. Ведь, создавая сайты, я по стандарту устанавливаю SSL-сертификаты к доменам, настраиваю их автопродление, переадресацию с HTTP на HTTPS и забываю о них. Моей основной задачей становится написание сервера с защитой от разного рода уязвимостей.

Представляем ClusterIssuer для автоматического выпуска SSL-сертификатов LE через REG.RU

2022-10-20 в 8:05, admin, рубрики: cert-manager, devops, kubernetes, regru, SSL, Блог компании Флант, системное администрированиеУ большинства популярных DNS-провайдеров есть API, с помощью которого можно управлять записями. Это позволяет автоматизировать заказ и продление SSL-сертификатов через DNS01.

В Kubernetes для работы с сертификатами используется cert-manager. Чтобы заказать сертификат в кластере, нужно объявить ресурс центра сертификации — например, ClusterIssuerЧитать полностью »

Шифрование сертификатов TLS — как формируется цифровая подпись

2022-09-24 в 18:58, admin, рубрики: Curve25519, Curve448, Ed25519, Ed448, ErDSA, Frost & Sullivan, globalsign, IT-стандарты, RFC 8032, SHA-2, SHA-512, SHAKE256, SSL, TLS, TLS 1.3 RFC 8446, Блог компании GlobalSign, информационная безопасность, криптография, Разработка веб-сайтов, сертификаты, цифровая подпись, шифрование, эллиптические кривые

По оценке независимой исследовательской и консалтинговой компании Frost & Sullivan, TLS-сертификаты от GlobalSign обеспечивают максимально надёжное шифрование. В том числе за это GlobalSign получила в сентябре 2022 года награду 2022 Global Competitive Strategy Leadership Award.

Но возникает вопрос, чем же отличается шифрование в разных сертификатах? В частности, какие алгоритмы используются для криптографической подписи?

Читать полностью »