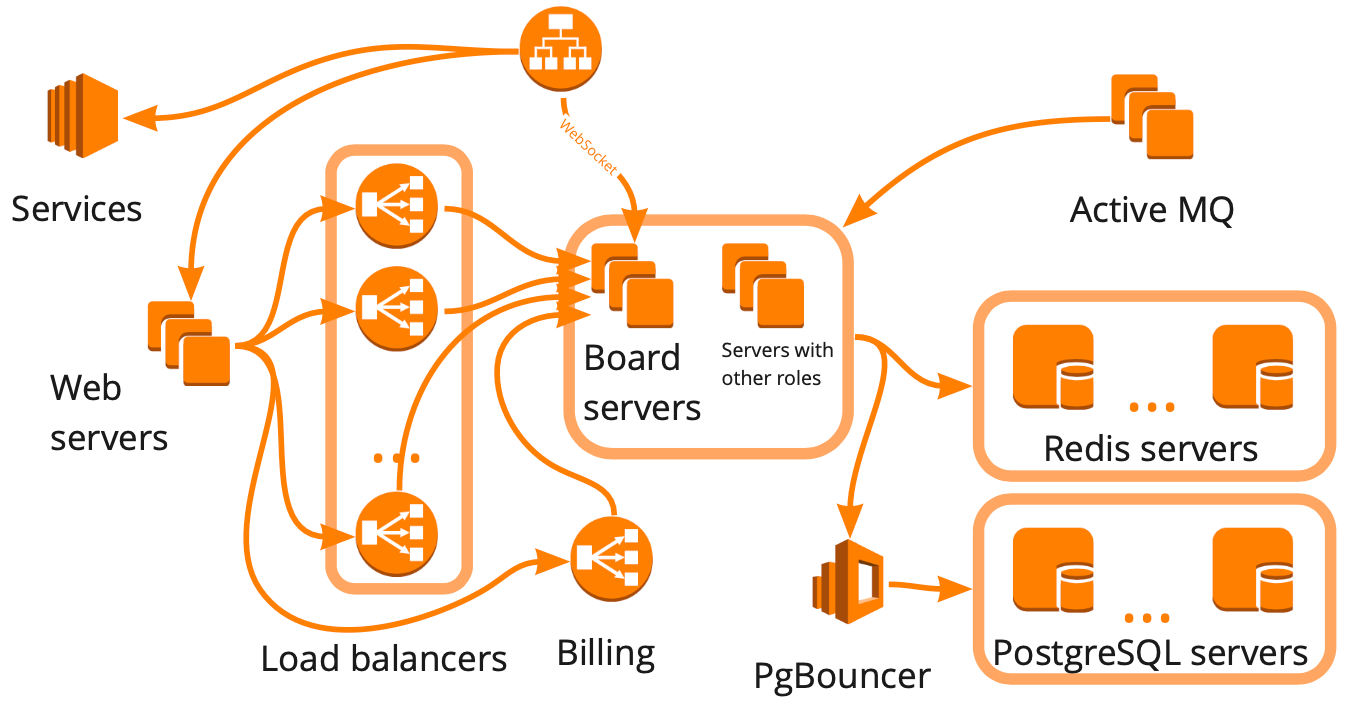

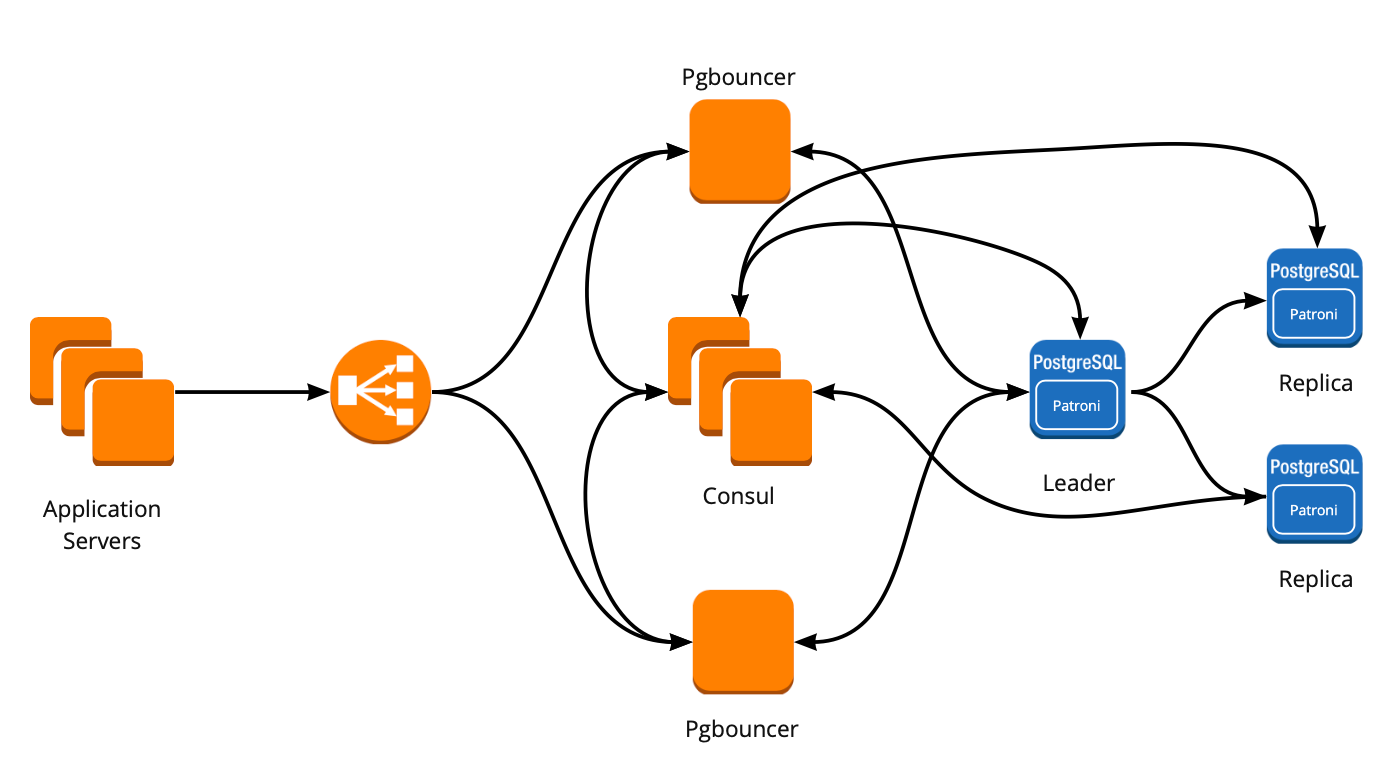

В прошлой статье я рассказал про нашу инфраструктуру большого нагрузочного теста. В среднем мы создаём порядка 100 серверов для подачи нагрузки и порядка 150 серверов для работы нашего сервиса. Все эти сервера нужно создавать, удалять, конфигурировать и запускать. Мы используем для этого те же инструменты, что и на проде, чтобы уменьшить количество ручной работы:

- Для создания и удаления тестового окружения — Terraform скрипты;

- Для конфигурирования, обновления и запуска — Ansible скрипты;

- Для динамического масштабирования в зависимости от нагрузки — самописные Python-скрипты.

Благодаря скриптам Terraform и Ansible, все операции от создания инстансов до запуска сервера выполняются всего шестью командами:

#запускаем нужные инстансы в консоли aws

ansible-playbook deploy-config.yml #обновляем версии серверов

ansible-playbook start-application.yml #запускаем наше приложение на этих серверах

ansible-playbook update-test-scenario.yml --ask-vault-pass #обновляем Jmeter сценарий, если в нём были изменения

infrastructure-aws-cluster/jmeter_clients:~# terraform apply #создаем jmeter сервера для подачи нагрузки

ansible-playbook start-jmeter-server-cluster.yml #запускаем jmeter кластер

ansible-playbook start-stress-test.yml #запускаем тест