Рубрика «хранилища данных»

Memory wall: что это и почему важно для индустрии хранения данных

2026-01-21 в 8:05, admin, рубрики: memorywall, SDS, selectel, платформа данных, хранилища данныхСтановятся ли жёсткие диски лучше? Спросим кривую отказов

2025-10-24 в 13:01, admin, рубрики: ruvds_перевод, анализ hdd, срок службы hdd, хранилища данных

Если вы уже давно знакомы с Backblaze (особенно, если следите за обзорами Drive Stats), то наверняка читали наши обсуждения кривой отказов. В статье «Drive Failure Over Time: The Bathtub Curve Is LeakingЧитать полностью »

Новый диск в облаке Selectel — настройте IOPS под свои задачи

2025-03-12 в 8:05, admin, рубрики: IOPS, selectel, облачные сервисы, сетевые диски, хранилища данных

Если вы работаете с облачными ресурсами и управляете инфраструктурой, то наверняка знаете, как важно правильно настроить дисковую подсистему. В Selectel появилась новая возможность: теперь в облаке можно самостоятельно регулировать производительность дисков, не привязываясь к фиксированным конфигурациям.

Это значит, что больше не нужно заранее выбирать «с запасом» или рисковать нехваткой производительности в пиковые моменты. Вы просто настраиваете параметры диска под свою нагрузку — и меняете их на лету. Без даунтайма, сложных миграций или дополнительных настроек.Читать полностью »

Почему мои ZFS-диски так шумят?

2024-10-04 в 13:01, admin, рубрики: proxmox, raidz, ruvds_перевод, zfs, снижение шума приводов, хранилища данных

Некоторое время назад пользователь Practical ZFS задал обманчиво простой вопрос:

«У меня есть пул Proxmox из трёх RAIDz1 vdev (virtual device, виртуальное устройство) по 4 диска. Проблема в том, что во время работы VM все двенадцать дисков минимум раз в секунду издают громкий звук, причём в течение всего дня. Что может быть причиной, и как это устранить?»

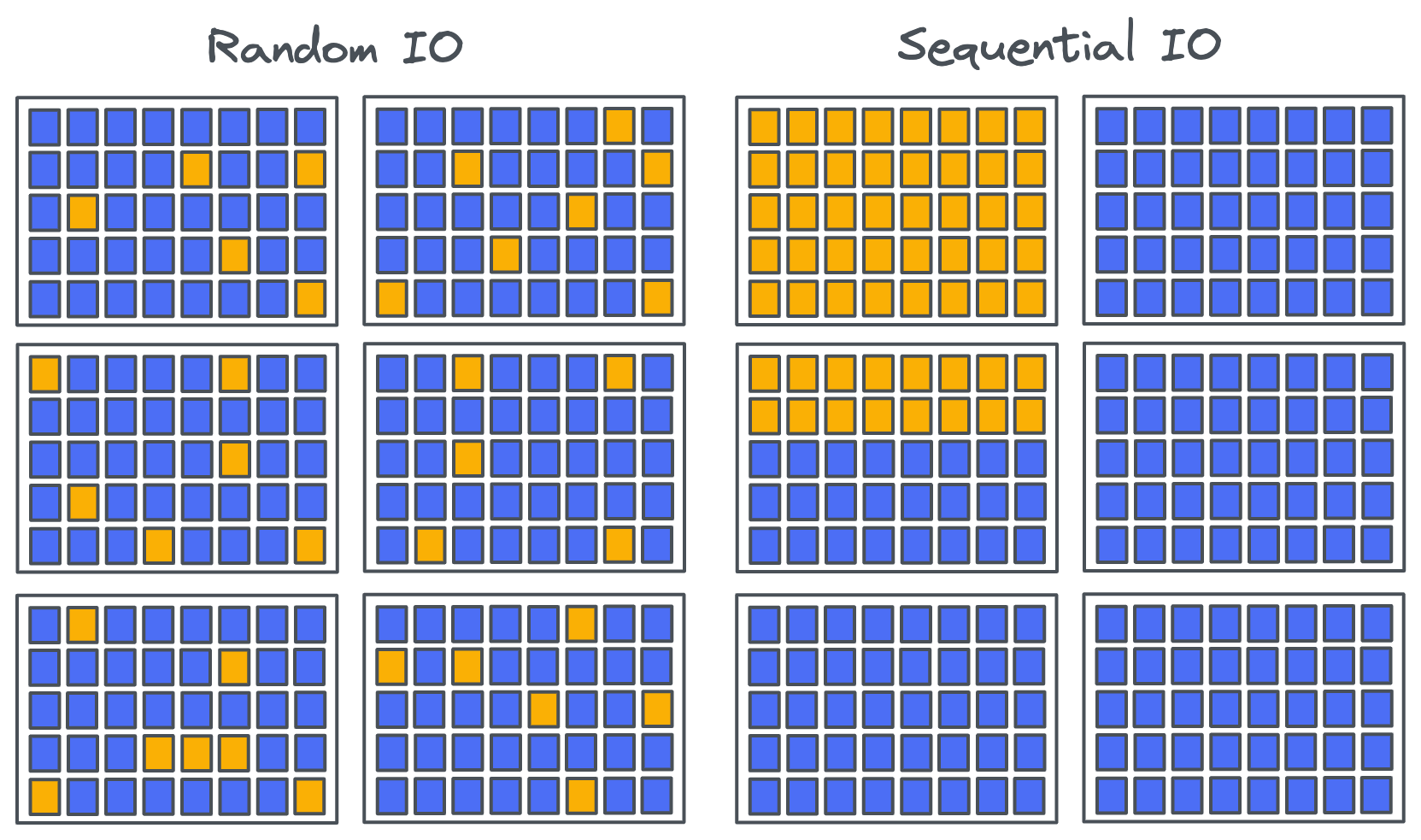

Мёртв ли последовательный ввод-вывод в эпоху накопителей NVMe?

2023-05-24 в 13:00, admin, рубрики: hdd, NVMe, ruvds_перевод, ssd, Блог компании RUVDS.com, Компьютерное железо, последовательный доступ, произвольный доступ, хранение данных, хранилища данных

Две системы, которые я хорошо знаю (Apache BookKeeper и Apache Kafka) проектировались в эпоху дисковых накопителей: жёстких дисков, или HDD. Жёсткие диски хорошо справляются с последовательным вводом-выводом, но не очень хороши в произвольном вводе-выводе из-за относительно большого времени поиска. Неудивительно, что и Kafka, и BookKeeper проектировались с расчётом на последовательный ввод-вывод.

И Kafka, и BookKeeper — это распределённые системы логирования, поэтому можно представить, что последовательный ввод-вывод будет стандартным режимом для системы хранения логов с возможностью только дополнения. Но последовательный и произвольный ввод-вывод находятся в спектре, где на одном краю расположен чисто последовательный, а на другом — чисто произвольный ввод-вывод. Если у вас есть пять тысяч файлов, которые вы дописываете небольшими циклическими операциями записи, и выполняете fsync, то это не такой уж последовательный паттерн доступа, он находится ближе к произвольному вводу-выводу. То есть если вы только дополняете логи, это не означает автоматически, что вы получаете последовательный ввод-вывод.

Читать полностью »

Что надёжнее, SSD или HDD? Холивар продолжается…

2023-05-08 в 8:01, admin, рубрики: American Bosch Arma, Backblaze, CHE-Channel Hot Electrons, Deallocate, hdd, mlc, nand, NAND 3D, NOR, PROM, Pure Storage, qlc, SATA, seagate, SLC, ssd-накопители, timeweb_статьи, tlc, trim, TRIMCheck, western digital, Блог компании Timeweb Cloud, Накопители, Серверное администрирование, хостинг, хранилища данных, энергонезависимая память

Почти семь лет назад (13 августа 2015 года) компания Samsung представила первый в мире SSD на 16 ТБ, но после этого бурное развитие как будто застопорилось. Где супердешёвые SSD на десятки терабайт, почему мы их не видим во всех компьютерах вокруг? Неужели до сих пор живы мифы о ненадёжности SSD?

Попробуем разобраться.

Читать полностью »

Домашний NAS сервер

2023-04-30 в 22:07, admin, рубрики: FTP, Git, linux, NAS, samba, web, wiki, Разработка под Linux, хранилища данных

Достаточно много читаю статей на Хабре, но сам никогда не писал... Буду стараться заполнить этот пробел и сегодня хочу представить статью на тему "Домашний NAS сервер"

Немного о себе...

Должность занимаю Инженер-программист ПЛИС, основные мои задачи:

Почему мы стали дороже в этом году

2023-04-25 в 11:35, admin, рубрики: ruvds_статьи, Блог компании RUVDS.com, ит-бизнес, финансы, финансы в IT, хостинг, хранение данных, хранилища данных, цодОтвечаю: потому что мы очень жадные!

Настолько жадные, что учли инфляцию, колебания курса, повышение стоимости лицензий Microsoft (а мы всё ещё не пиратим), допиздержки на серый импорт железа, повышение цен на IP-адреса и глобальное потепление. Повысили цены и всё равно остались примерно в 2–4 раза дешевле облака одного очень российского поисковика.

В общем, такие времена. Кто-то разливает молоко в пакет по 0,9 литра, а кто-то покупает в VDS-хостинг десктопное железо. Но мы уже выросли достаточно, чтобы понимать, что такое планирование вдолгую, и знаем, что важно нашим клиентам.

А нашим клиентам важно, чтобы всё шло без сюрпризов. Последние три года и так выдались удивительные, и какие-нибудь новости от хостинга — это не то, что они хотели бы.

Читать полностью »

Ещё эпические фейлы при открытии в Казахстане (почему мы так задержались)

2023-04-20 в 7:01, admin, рубрики: ruvds_статьи, Блог компании RUVDS.com, ит-бизнес, Казахстан, управление проектами, хостинг, хранение данных, хранилища данных, цод

В прошлый раз я рассказал про то, как «учёный изнасиловал журналиста». Кратко: мы выпустили релиз, что встаём в ЦОДы «Транстелекома», «Форбс Казахстан» написал, что мы совместно открываем два ЦОДа, дальше наши «новообретённые» партнёры узнали много нового о себе и своих стратегических партнёрствах и очень удивились. Про эти приключения в прошлом посте.

Это не первый опыт наших эпик фейлов в Казахстане.

Оставалось купить железо, настроить оплаты и заехать в ЦОДы.

Естественно, кое-что пошло не так.

Читать полностью »