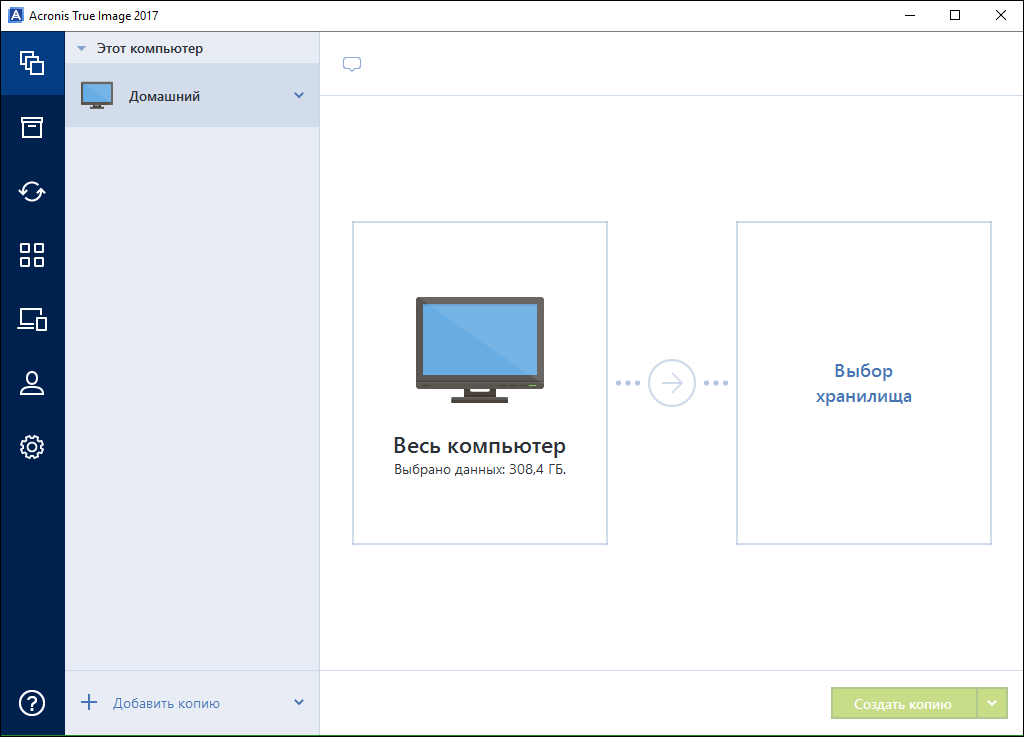

У нас недавно был праздник — вышел в релиз True Image 2017, над которым мы работали целый год. Изменений очень много, но первое, что бросается в глаза, – это «казуальный» минималистичный дизайн. Если наши первые релизы были инструментами продвинутых пользователей и сисадминов, то последние несколько лет мировая популярность продукта такова, что бэкапят им очень и очень разные люди. В том числе те, кто не особо отличает монитор от системного блока.

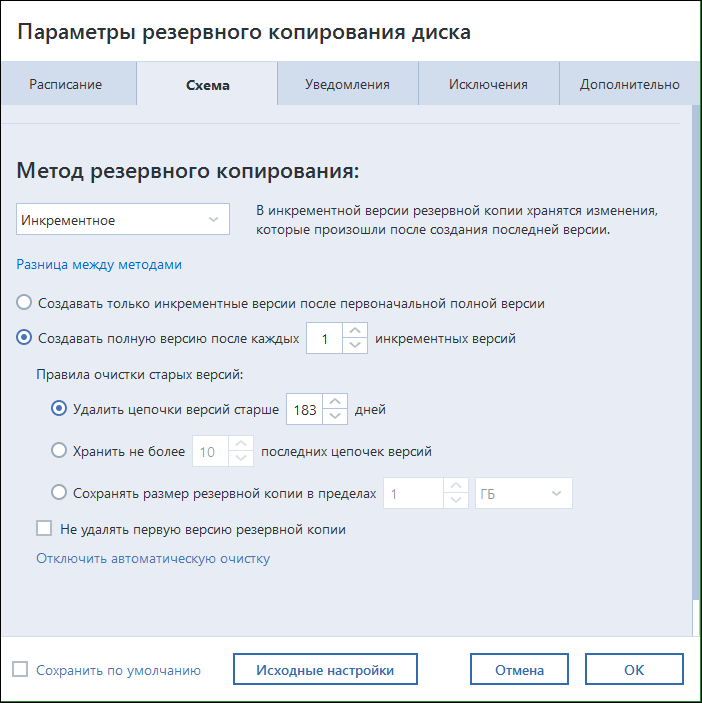

Поэтому наш подход – сохранить весь старый добрый хардкор, гибкость настроек и множество нетривиальных инструментов, но сделать упор на упрощение интерфейса.

На первом месте – основные действия с заведомо хорошими умолчаниями

Но все настройки на месте

Ещё в этом релизе мы научились делать локальный бэкап iOS и Android на ваш десктоп, бэкапить профиль Facebook (спасибо пользователю Маша Ведро), поработали с архитектурой архива и так далее. Расскажу про основные фичи и сложности в их разработке.Читать полностью »